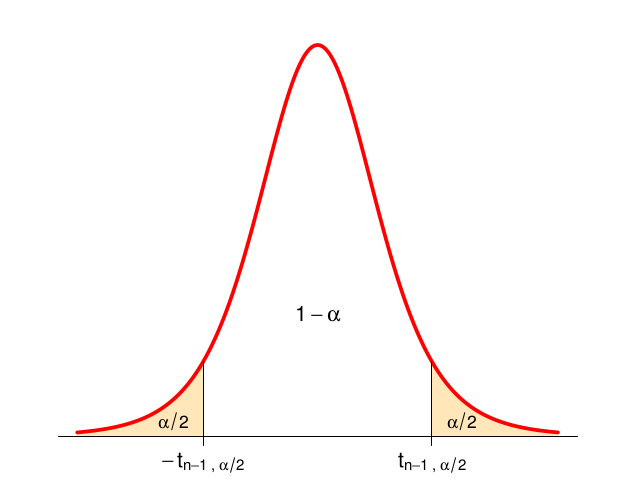

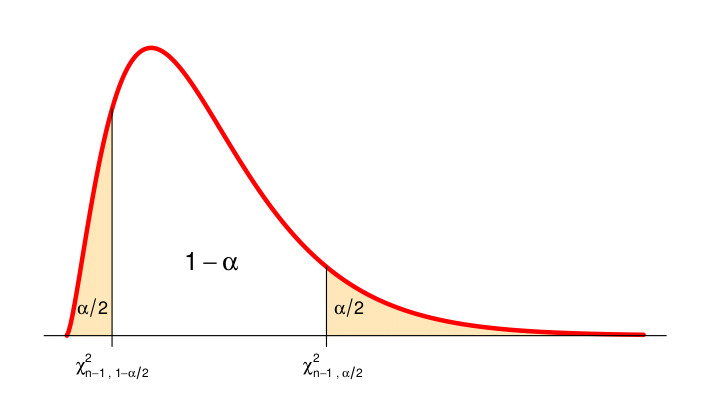

class: center, middle, inverse, title-slide # Tema 3: Distribuciones de Probabilidad Notables: Distribuciones relacionadas con la Normal ### <br><br>Estadística. Grado en Ciencias del Mar --- ## Distribuciones relacionadas con la normal * t de Student `\(t_n\)`: [William S. Gosset (_Student_)](https://es.wikipedia.org/wiki/William_Sealy_Gosset) * Chi-cuadrado `\(\chi^2_n\)`: [Karl Pearson](https://es.wikipedia.org/wiki/Karl_Pearson) * F de Fisher `\(F_{{n_1},{n_2}}\)`: [Ronald A. Fisher](https://es.wikipedia.org/wiki/Ronald_Fisher) <center>    </center> <center> <font size = "3"> W. Gosset (1876-1937) K. Pearson (1857-1936) R. Fisher (1890-1962) </font> </center> --- ## Distribución t de Student: `\(t_n\)` Si `\(\bar{X}\)` y `\(s\)` son, respectivamente, la media y desviación típica de una muestra de `\(n\)` observaciones de una variable `\(X\approx N(\mu,\sigma)\)` se cumple que: .resalta[ `$$\large {\frac{\bar{X}-\mu}{s/\sqrt{n}}\approx t_{n-1}}$$` ] <br> Utilizando la aplicación, podemos encontrar el valor `\(t_{n,\alpha/2}\)` tal que `\(P(t_n>t_{n,\alpha/2})=\alpha/2\)`, de tal forma que: `$$P\left({-t_{n-1,\alpha/2}\le\frac{\bar{X}-\mu}{s/\sqrt{n}}\le t_{n-1,\alpha/2}}\right)=1-\alpha$$` <br> [Ver el trabajo original de Gosset en el que se obtiene la distribución t](pdf/student.pdf) --- ## Distribución t de Student: `\(t_n\)` Gráficamente:  `$$P\left({-t_{n-1,\alpha/2}\le\frac{\bar{X}-\mu}{s/\sqrt{n}}\le t_{n-1,\alpha/2}}\right)=1-\alpha$$` --- El resultado anterior puede expresarse también de la forma: `$$P\left({\left|\bar{X}-\mu\right|\le t_{n-1,\alpha/2}\frac{s}{\sqrt{n}}}\right)=1-\alpha$$` -- Una vez tomados los datos, ya `\(\bar{X}\)` no es una variable aleatoria sino un valor fijo, y la expresión anterior suele enunciarse diciendo que: -- .resalta[ _Con una confianza `\(\;1-\alpha\;\)` podemos asegurar que la media poblacional `\(\mu\)` se diferencia de la media muestral `\(\bar{X}\)` en menos de_ `\(t_{n-1,\alpha/2}\frac{s}{\sqrt{n}}\)` _unidades_ ] -- o dicho de otra forma: .resalta[ _Con una confianza `\(\;1-\alpha\;\)` podemos asegurar que la media poblacional `\(\mu\)` se encuentra en el intervalo_ `\(\left[\bar{X}\pm t_{n-1,\alpha/2}\frac{s}{\sqrt{n}}\right]\)` ] --- ## Distribución Chi-Cuadrado de Pearson: `\(\chi^{2}_n\)` Sea `\(s^2\)` la varianza de una muestra de `\(n\)` observaciones de una variable `\(X\approx N(\mu,\sigma)\)`. _Antes de tomar la muestra_, `\(s^2\)` es una variable aleatoria y se cumple que: .resalta[ `$$\frac{{(n-1)s^{2}}}{{\sigma^{2}}}\approx\chi_{n-1}^{2}$$` ] Utilizando la aplicación, podemos encontrar los valores `\(\chi_{n-1,\alpha/2}\)` y `\(\chi_{n-1,1-\alpha/2}\)` tales que `$$P(\chi_{n-1}>\chi_{n-1,\alpha/2})=\alpha/2$$` `$$P(\chi_{n-1}>\chi_{n-1,1-\alpha/2})=1-\alpha/2$$` de tal forma que: `$$P\left({\chi_{n-1,1-\alpha/2}\le\frac{{(n-1)s^{2}}}{{\sigma^{2}}}\le \chi_{n-1,\alpha/2}}\right)=1-\alpha$$` --- ## Distribución Chi-Cuadrado de Pearson: `\(\chi^{2}_n\)` Gráficamente:  `$$P\left({\chi_{n-1,1-\alpha/2}\le\frac{{(n-1)s^{2}}}{{\sigma^{2}}}\le \chi_{n-1,\alpha/2}}\right)=1-\alpha$$` --- ## Distribución Chi-Cuadrado de Pearson: `\(\chi^{2}_n\)` La expresión: `$$P\left({\chi_{n-1,1-\alpha/2}\le\frac{{(n-1)s^{2}}}{{\sigma^{2}}}\le \chi_{n-1,\alpha/2}}\right)=1-\alpha$$` puede expresarse de forma equivalente como: `$$P\left(\frac{\chi_{n-1,1-\alpha/2}^{2}}{(n-1)s^2}\le\frac{1}{\sigma^{2}}\le\frac{\chi_{n-1,\alpha/2}^{2}}{(n-1)s^2}\right)=1-\alpha$$` -- o también, invirtiendo las fracciones: `$$P\left(\frac{(n-1)s^2}{\chi_{n-1,\alpha/2}^{2}}\le\sigma^{2}\le\frac{(n-1)s^2}{\chi_{n-1,1-\alpha/2}^{2}}\right)=1-\alpha$$` --- ## Distribución Chi-Cuadrado de Pearson: `\(\chi^{2}_n\)` <br> Una vez tomada la muestra `\(s^2\)` no es una variable aleatoria, sino un valor fijo. En este momento, la expresión anterior se interpreta diciendo que: .resalta[ _Con una confianza `\(\;1-\alpha\;\)` podemos asegurar que la varianza `\(\sigma^2\)` de la población se encuentra en el intervalo:_ `$$\left[\frac{(n-1)s^2}{\chi_{n-1,\alpha/2}^{2}}, \frac{(n-1)s^2}{\chi_{n-1,1-\alpha/2}^{2}}\right]$$` ] --- ## Distribución F de Fisher: `\(F_{{n_1},{n_2}}\)` Supongamos que se van a tomar dos __muestras aleatorias independientes__ de tamaños respectivos `\(n_{1}\)` y `\(n_{2}\)`, de dos distribuciones normales con varianzas respectivas `\(\sigma_{1}^{2}\)` y `\(\sigma_{2}^{2}\)`. Sean `\(s^2_1\)` y `\(s^2_2\)` las varianzas de estas muestras. _Antes de realizar el muestreo_ `\(s^2_1/s^2_2\)` _es una variable aleatoria que cumple_: .resalta[ `$$\large{\frac{{s_{1}^{2}/s_{2}^{2}}}{{\sigma_{1}^{2}/\sigma_{2}^{2}}}\approx F_{n_{1}-1,n_{2}-1}}$$` ] de donde se sigue que: `$$P\left({F_{n_{1}-1,n_{2}-1,1-\alpha/2}\le\frac{{s_{1}^{2}/s_{2}^{2}}}{{\sigma_{1}^{2}/\sigma_{2}^{2}}}\le F_{n_{1}-1,n_{2}-1,\alpha/2}}\right)=1-\alpha$$` --- ## Distribución F de Fisher: `\(F_{{n_1},{n_2}}\)` Gráficamente: <img src="tema3B_Distribuciones_Relacionadas_Normal_files/figure-html/unnamed-chunk-1-1.png" style="display: block; margin: auto;" /> `$$P\left({F_{n_{1}-1,n_{2}-1,1-\alpha/2}\le\frac{{s_{1}^{2}/s_{2}^{2}}}{{\sigma_{1}^{2}/\sigma_{2}^{2}}}\le F_{n_{1}-1,n_{2}-1,\alpha/2}}\right)=1-\alpha$$` --- Esta expresión también puede escribirse como: `$$P\left(\frac{1}{F_{n_{1}-1,n_{2}-1,\alpha/2}}\le\frac{\sigma_{1}^{2}/\sigma_{2}^{2}}{s_{1}^{2}/s_{2}^{2}}\le\frac{1}{F_{n_{1}-1,n_{2}-1,1-\alpha/2}}\right)=1-\alpha$$` -- o lo que es lo mismo: `$$P\left(\frac{s_{1}^{2}/s_{2}^{2}}{F_{n_{1}-1,n_{2}-1,\alpha/2}}\le\frac{\sigma_{1}^{2}}{\sigma_{2}^{2}}\le\frac{s_{1}^{2}/s_{2}^{2}}{F_{n_{1}-1,n_{2}-1,1-\alpha/2}}\right)=1-\alpha$$` -- Una vez tomada la muestra, `\(\frac{s^2_1}{s^2_2}\)` no es una variable aleatoria sino un valor fijo, y el intervalo anterior se interpreta diciendo que: .resalta[ _Con probabilidad_ `\(\;1-\alpha\;\)` _el cociente_ `\(\frac{\sigma_{1}^{2}}{\sigma_{2}^{2}}\)` _se encuentra comprendido en el intervalo_: `$$\left[\frac{s_{1}^{2}/s_{2}^{2}}{F_{n_{1}-1,n_{2}-1,\alpha/2}}, \frac{s_{1}^{2}/s_{2}^{2}}{F_{n_{1}-1,n_{2}-1,1-\alpha/2}}\right]$$` ] --- ## .blue[Ejemplo] Se ha desarrollado un nuevo pienso para alimentar a peces criados en cultivos marinos. Para valorar la eficiencia de este pienso se han seleccionado aleatoriamente 40 alevines de similares características, se han pesado, se han marcado para poder identificarlos y se han devuelto al tanque de cultivo. Transcurridos seis meses, los 40 peces son vueltos a pesar y se anota para cada uno de ellos el incremento de peso experimentado durante este periodo. Los incrementos de peso (en gramos) registrados fueron los siguientes: <table class="table" style="margin-left: auto; margin-right: auto;"> <tbody> <tr> <td style="text-align:right;"> 1226 </td> <td style="text-align:right;"> 988 </td> <td style="text-align:right;"> 1326 </td> <td style="text-align:right;"> 1246 </td> <td style="text-align:right;"> 1346 </td> <td style="text-align:right;"> 1258 </td> <td style="text-align:right;"> 1216 </td> <td style="text-align:right;"> 925 </td> <td style="text-align:right;"> 1156 </td> <td style="text-align:right;"> 1158 </td> </tr> <tr> <td style="text-align:right;"> 1328 </td> <td style="text-align:right;"> 988 </td> <td style="text-align:right;"> 1277 </td> <td style="text-align:right;"> 1242 </td> <td style="text-align:right;"> 1141 </td> <td style="text-align:right;"> 939 </td> <td style="text-align:right;"> 1179 </td> <td style="text-align:right;"> 1370 </td> <td style="text-align:right;"> 1139 </td> <td style="text-align:right;"> 1321 </td> </tr> <tr> <td style="text-align:right;"> 1331 </td> <td style="text-align:right;"> 1356 </td> <td style="text-align:right;"> 1087 </td> <td style="text-align:right;"> 1257 </td> <td style="text-align:right;"> 1156 </td> <td style="text-align:right;"> 1402 </td> <td style="text-align:right;"> 1209 </td> <td style="text-align:right;"> 1020 </td> <td style="text-align:right;"> 1108 </td> <td style="text-align:right;"> 1060 </td> </tr> <tr> <td style="text-align:right;"> 1109 </td> <td style="text-align:right;"> 1144 </td> <td style="text-align:right;"> 1143 </td> <td style="text-align:right;"> 1301 </td> <td style="text-align:right;"> 1308 </td> <td style="text-align:right;"> 1537 </td> <td style="text-align:right;"> 1511 </td> <td style="text-align:right;"> 1061 </td> <td style="text-align:right;"> 981 </td> <td style="text-align:right;"> 1306 </td> </tr> </tbody> </table> -- <br> * Media: `\(\bar{X}=\)` 1203.9 * Desviación típica: `\(s =\)` 146.91 --- ## .blue[Ejemplo] __1.__ Con la información aportada por este experimento, ¿en qué intervalo podemos esperar que se encuentre el incremento medio de peso en la población de peces? (calcula el intervalo con una confianza del 95%) -- El intervalo en este caso es: `$$\left[\bar{X}\pm t_{n-1,\alpha/2}\frac{s}{\sqrt{n}}\right] = \left[1203.9\pm t_{39,0.025}\frac{146.91}{\sqrt{40}}\right]$$` -- Mediante la aplicación podemos obtener `\(t_{39,0.025}=2.0227\)`, y por tanto: `$$t_{39,0.025}\frac{146.91}{\sqrt{40}}=46.98$$` -- Sustituyendo obtenemos el intervalo: `$$\left[1156.92, 1250.88 \right]$$` -- Por tanto, con una confianza del 95% el incremento medio de peso en la población de peces está entre 1156.92 y 1250.88 gramos. --- ## .blue[Ejemplo] __2.__ Con la información aportada por este experimento, ¿en qué intervalo podemos esperar que se encuentre la desviación típica del peso en la población de peces? (calcula el intervalo con una confianza del 95%) -- El intervalo a utilizar ahora es: `$$\sigma^2 \in \left[\frac{(n-1)s^2}{\chi_{n-1,\alpha/2}^{2}}, \frac{(n-1)s^2}{\chi_{n-1,1-\alpha/2}^{2}}\right] = \left[\frac{39\cdot 146.91^2}{\chi_{39,0.025}^{2}}, \frac{39\cdot 146.91^2}{\chi_{39,0.975}^{2}}\right]$$` -- Mediante la aplicación obtenemos: `$$\chi_{39,0.025}^{2}=58.12\;\;\;\;\;\;\; \chi_{39,0.975}^{2}=23.65$$` -- y sustituyendo: `$$\sigma^2 \in \left[14482.62,35591.10\right]$$` -- Tomando raíces cuadradas: `$$\sigma \in \left[120.34,188.66\right]$$` --- ## .blue[Ejemplo] __3.__ Se ha realizado un experimento similar con otros 50 peces, utilizando otro pienso con un mayor contenido en proteínas e hidratos de carbono. En este segundo experimento la desviación típica observada en el incremento de peso fue de 205.62 gramos. Con esta información ¿Contamos con evidencia suficiente para asegurar que los dos piensos producen distinta variabilidad en la ganancia en peso de los peces que los consumen? -- Para responder a esta pregunta calculamos un intervalo para el cociente de las varianzas observadas en ambos experimentos: `$$\small \frac{\sigma^2_1}{\sigma^2_2} \in \left[\frac{s_{1}^{2}/s_{2}^{2}}{F_{n_{1}-1,n_{2}-1,\alpha/2}}, \frac{s_{1}^{2}/s_{2}^{2}}{F_{n_{1}-1,n_{2}-1,1-\alpha/2}}\right]= \left[\frac{146.91^2/205.62^2}{F_{39,49,0.025}},\frac{146.91^2/205.62^2}{F_{49,39,0.975}}\right]$$` -- Mediante la aplicación obtenemos: `$$F_{39,49,0.025} = 1.8082\;\;\;\;\;\; F_{39,49,0.975}= 0.5416$$` -- y sustituyendo: `$$\frac{\sigma^2_1}{\sigma^2_2} \in \left[\frac{0.51}{1.8082}, \frac{0.51}{0.5416}\right]=\left[0.28, 0.94\right]$$` --- ## .blue[Ejemplo] Como el intervalo obtenido es: `$$\frac{\sigma^2_1}{\sigma^2_2} \in \left[\frac{0.51}{1.8082}, \frac{0.51}{0.5416}\right]=\left[0.28, 0.94\right]$$` podemos estamos "seguros" con un 95% de confianza de que el cociente de estas varianzas es algún valor entre 0.28 y 0.94, esto es, __un valor menor que 1__. De esta forma podemos decir (con esa confianza) que el experimento contiene evidencia suficiente para afirmar que la ganancia de peso con el pienso 1 presenta menor variabilidad que con el pienso 2. -- Por último, señalemos que si deseáramos un intervalo de confianza para el cociente de desviaciones típicas, bastaría con tomar raíces cuadradas en la expresión anterior: `$$\frac{\sigma_1}{\sigma_2} \in \left[\sqrt{\frac{0.51}{1.8082}}, \sqrt{\frac{0.51}{0.5416}}\right]=\left[0.53, 0.97\right]$$` es decir, el valor de `\(\sigma_1\)` es entre un 53% y un 97% del valor de `\(\sigma_2\)`. --- ## Teorema Central del Límite: Aplicaciones El Teorema Central del Límite establece que dada una colección de variables aleatorias __independientes__ `\(X_1, X_2, \dots, X_n\)` tales que `\(E[X_i]=\mu_i\)` y `\(Var(X_i)=\sigma^2_i\)`, cuando `\(n\rightarrow\infty\)` la distribución de probabilidad de la suma de estas variables es aproximadamente normal: .resalta[ `$$\sum_{i=1}^{n}X_{i}\approx N\left(\sum_{i=1}^{n}\mu_{i},\;\sqrt{\sum_{i=1}^{n}\sigma_{i}^{2}}\right)$$` ] En el caso particular de que todas las `\(X_i\)` tengan la misma distribución, esto es, `\(E[X_i]=\mu\)` y `\(Var(X_i)=\sigma^2\)` `\(\forall i\)` se tiene que: .resalta[ `$$\sum_{i=1}^{n}X_{i}\approx N\left(n\mu,\;\sigma\sqrt{n}\right)$$` ] --- ## Aplicaciones del TCL: aproximación de la Binomial por la Normal: Si `\(X\)` es una variable `\(B\left(n,p\right)\)`, su valor representa el número de éxitos en `\(n\)` experimentos independientes en cada uno de los cuales la probabilidad de éxito es `\(p\)`. -- Si definimos el resultado de cada experimento como: `$$X_{i}=\begin{cases} 0 & 1-p\;\;\textrm{(fracaso)}\\ 1 & p\;\;\;\;\;\;\;\;\textrm{(éxito)} \end{cases}\;\;\;\;\;\textrm{(Variable de Bernoulli)}$$` -- podemos expresar la binomial como suma de variables de Bernoulli: `$$X = X_1+X_2+\dots+X_n$$` -- Obsérvese que: `$$\mu_i=E[X_i]=1\cdot p + 0\cdot (1-p)=p$$` `$$\sigma^2_i=Var(X_i)=E[X^2_i]-\left(E[X_i]\right)^2=1^2\cdot p+0^2\cdot (1-p)-p^2=p(1-p)$$` --- ## Aplicaciones del TCL: aproximación de la Binomial por la Normal Entonces, si el valor de `\(n\)` es grande: .resalta[ `$$B(n,p)\approx X=\sum_{i=1}^{n}X_{i}\underset{n\rightarrow\infty}{\approx} N\left(n\mu,\;\sigma\sqrt{n}\right)=N\left(np,\sqrt{np(1-p)}\right)$$` ] -- <br> * En general la aproximación es razonablemente buena cuando `\(n\ge 30\)`, `\(np\ge 5\)` y `\(n(1-p)\ge 5\)` -- * Como la normal es continua y la binomial es discreta, en el cálculo aproximado se considera que el valor (discreto) `\(k\)` es equivalente al intervalo `\(\left[k-\frac{1}{2},k+\frac{1}{2}\right]\)` --- ## .blue[Ejemplo:] Si `\(X\approx B(120,0.35)\)`, se puede aproximar por `$$X_N\approx N(120\cdot 0.35, \sqrt{120\cdot 0.35\cdot 0.65}= N(42,5.2249)$$` -- Entonces: * `\(P(X=40) = 0.0716\)` (Valor exacto) * `\(P(X=40)\cong P(39.5<X_{N}<40.5)=P(X_{N}<40.5)-P(X_{N}<39.5)=\)` `\(\;\;\;\;\;\;\;\;\;\;\;\;\;\;=\;0.387-0.3162=0.0709\)` (Valor aproximado) <br> -- * `\(P(X\le 40) = 0.3905\)` (Valor exacto) * `\(P(X\le 40)\cong P(X_{N}\le 40.5) = 0.387\)` (Valor aproximado) <br> -- * `\(P(X \ge 40) = 0.6811\)` (Valor exacto) * `\(P(X\ge 40)\cong P(X_{N}\ge 39.5) = 0.6838\)` (Valor aproximado) --- ## Aproximación de la Binomial por la Normal Supongamos que `\(X\approx B(n,p)\)` es el número de éxitos en `\(n\)` pruebas independientes; si realizáramos efectivamente este experimento, `\(\hat{p}=\frac{X}{n}\)` sería la __proporción observada__ de éxitos en esas `\(n\)` pruebas. Si `\(n\)` es grande: `$$X\approx N\left(np,\sqrt{np\left(1-p\right)}\right)$$` -- y por tanto: `$$\hat{p}=\frac{X}{n}\approx N\left(\frac{np}{n},\frac{\sqrt{np\left(1-p\right)}}{n}\right)=N\left(p,\sqrt{\frac{p\left(1-p\right)}{n}}\right)$$` -- De aquí se sigue que: .resalta[ `$$\frac{\hat{p}-p}{\sqrt{\frac{p\left(1-p\right)}{n}}}\approx N\left(0,1\right)$$` ] --- ## Aproximación de la Binomial por la Normal Utilizando la distribución normal `\(N(0,1)\)`, podemos encontrar el valor `\(z_{\alpha/2}\)` tal que: `$$P\left(-z_{\alpha/2}\le\frac{\hat{p}-p}{\sqrt{\frac{p\left(1-p\right)}{n}}}\le z_{\alpha/2}\right)=1-\alpha$$` -- <br> De aquí se deduce que la diferencia entre el valor (desconocido) de `\(p\)` y el valor (observado) `\(\hat{p}\)` en la muestra cumple: .resalta[ `$$P\left(\left|\hat{p}-p\right|\le z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\right)=1-\alpha$$` ] Este resultado es aproximado, y sólo es válido si `\(n\ge 30\)`, `\(np\ge 5\)` y `\(n(1-p)\ge 5\)`. --- ## Aproximación de la Binomial por la Normal La probabilidad anterior puede expresarse también como: `$$P\left(\left|p-\hat{p}\right|\le z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\right)=1-\alpha$$` o lo que es lo mismo: `$$P\left(-z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\le p-\hat{p}\le z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\right)=1-\alpha$$` -- y de aquí: `$$P\left(\hat{p}-z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\le p\le \hat{p}+ z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\right)=1-\alpha$$` -- esto es, `$$P\left(p\in \left[\hat{p}-z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}},\hat{p}+ z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\right]\right)=1-\alpha$$` --- ## Aproximación de la Binomial por la Normal Una vez realizado el experimento, `\(\hat{p}\)` _no es una variable aleatoria, sino un valor fijo_. Podemos decir entonces que tenemos una confianza `\(1-\alpha\)` en que el valor (desconocido) de `\(p\)` cae en el intervalo: `$$p\in \left[\hat{p}-z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}},\hat{p}+z_{\alpha/2}\sqrt{\frac{p\left(1-p\right)}{n}}\right]$$` -- <br> Ahora bien, este intervalo es poco útil en la práctica, ya que sus extremos dependen de `\(p\)`, que es desconocido. Una opción es sustituirlo por el valor observado `\(\hat{p}\)`: `$$\left[\hat{p}-z_{\alpha/2}\sqrt{\frac{\hat{p}\left(1-\hat{p}\right)}{n}},\hat{p}+z_{\alpha/2}\sqrt{\frac{\hat{p}\left(1-\hat{p}\right)}{n}}\right]$$` (_intervalo de Wald_) aunque, como es obvio, no podemos garantizar entonces que se consigue la confianza deseada `\(1-\alpha\)`. .red[ __Por ello no es recomendable utilizar este intervalo en la práctica__]. --- ## Aproximación de la Binomial por la Normal En [Agresti & Caffo, 2000](pdf/agresti_caffo_2000.pdf) se señala como la aproximación del intervalo de Wald (al 95% de confianza) anterior mejora notablemente si se añaden 4 pseudo-observaciones a la muestra, 2 éxitos y 2 fracasos. De esta forma: * n se sustituye por `\(\widetilde{n}=n+4\)` * El número de éxitos `\(X\)` se sustituye por `\(X+2\)`. Por tanto la proporción observada de éxitos `\(\hat{p}\)` se sustituye por `\(\widetilde{p}=\frac{X+2}{n+4}\)` * El intervalo ajustado para `\(p\)` (_intervalo de Agresti-Coull_) es entonces: .resalta[ `$$\left[\widetilde{p}-z_{\alpha/2}\sqrt{\frac{\widetilde{p}\left(1-\widetilde{p}\right)}{\widetilde{n}}},\widetilde{p}+z_{\alpha/2}\sqrt{\frac{\widetilde{p}\left(1-\widetilde{p}\right)}{\widetilde{n}}}\right]$$` ] --- ## .blue[Ejemplo] Se desea conocer la proporción de hembras en una población de peces. Con este fin se obtiene una muestra de 200 peces elegidos aleatoriamente en esta población. En la muestra 140 peces son hembras. ¿Cuál es la proporción de hembras en esa población? -- La proporción de hembras en la muestra es `\(\frac{140}{200}=0.7 \cong 70\%\)`. Para evaluar el margen de error con que la proporción de hembras en la población se aproxima a este valor calculamos el intervalo de Agresti-Coull: * `\(\widetilde{n}=200+4\)` * `\(\widetilde{p} = \frac{142}{204}= 0.6961\)` -- * `\(\left[\widetilde{p}-z_{\alpha/2}\sqrt{\frac{\widetilde{p}\left(1-\widetilde{p}\right)}{\widetilde{n}}},\widetilde{p}+z_{\alpha/2}\sqrt{\frac{\widetilde{p}\left(1-\widetilde{p}\right)}{\widetilde{n}}}\right] = \left[0.6961\pm1.96\cdot0.0322\right]=\)` `$$=\left[0.633,0.759\right]$$` -- Por tanto a partir de estos datos podemos tener una confianza aproximada del 95% en que la proporción de hembras en la población es un valor comprendido entre el 63.3% y el 75.9%.