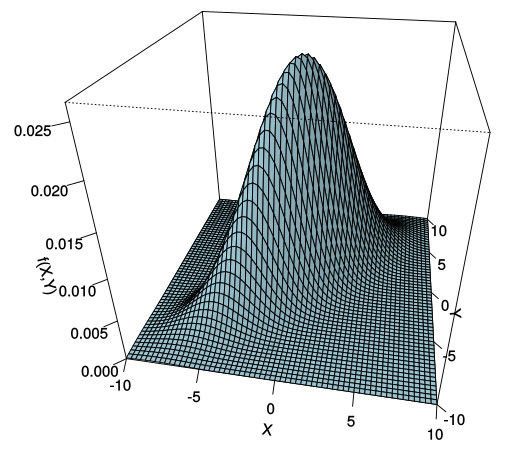

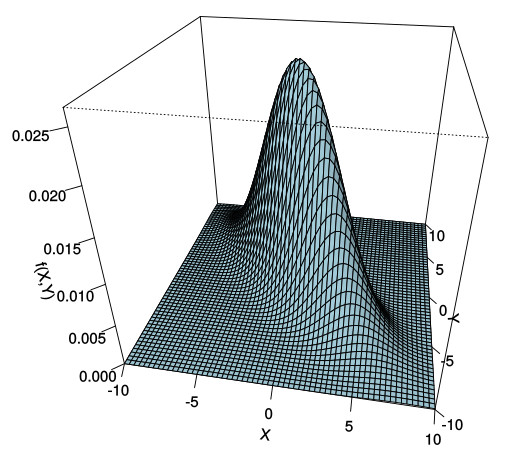

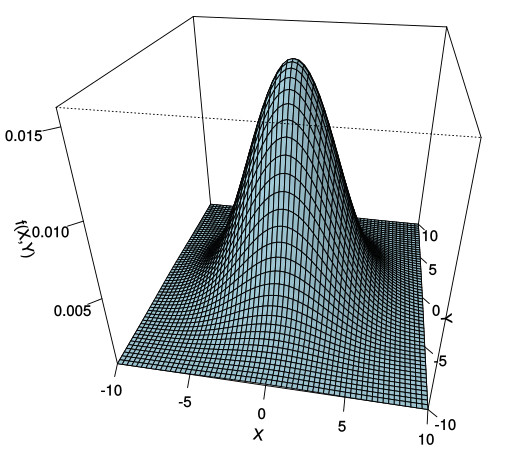

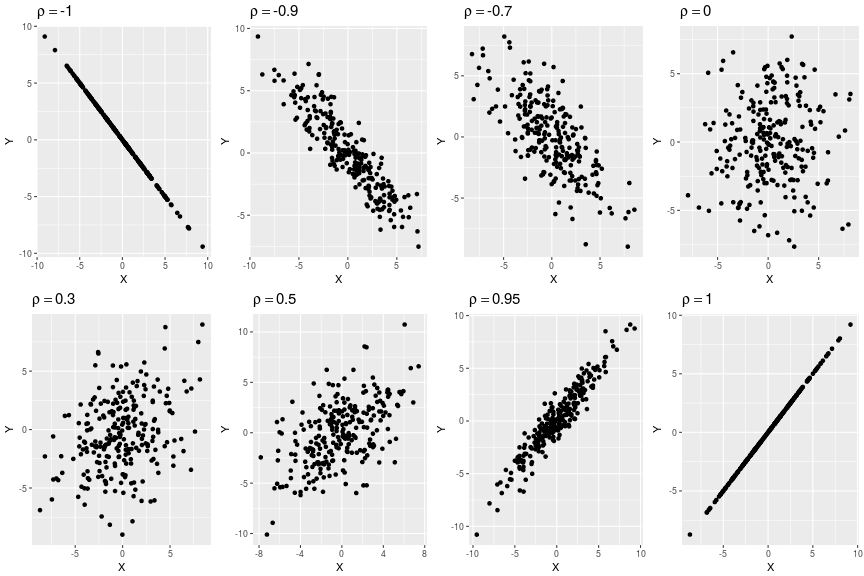

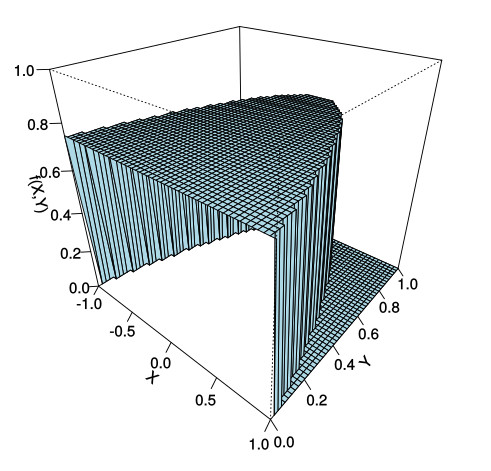

class: center, middle, inverse, title-slide # Estadística y Procesos Estocásticos <br> Tema 3: Distribuciones Multivariantes ### <br><br><br><br><br><br><br>Grado en Ingeniería en Tecnologías de la Telecomunicación --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/asp/descargas/azar.jpg) background-size: cover background-position: 15% 45% class: inverse, top, left # 5. Funciones de vectores aleatorios --- ## Esperanza de una función de un vector aleatorio ### .blue[ __1.__ Caso discreto] Si `\(\large{(X,Y)}\)` es un vector aleatorio de variables discretas y `\(\large{g(x,y)}\)` es una función de `\(\mathbb{R}^2\)` en `\(\mathbb{R}\)` tal que: `$$\sum_{x}\sum_{y}\left|g(x,y)\right|\cdot P(X=x,Y=y)<\infty$$` se define la esperanza de la función `\(g(X,Y)\)` como: .resalta[ `$$\Large{E[g(X,Y)]=\sum_{x}\sum_{y}g(x,y)\cdot P(X=x,Y=y)}$$` ] --- ## Esperanza de una función de un vector aleatorio ### .blue[ __2.__ Caso continuo] Si `\((X,Y)\)` es un vector de variables aleatorias continuas con función de densidad conjunta `\(f(x,y)\)` y se cumple que: `$$\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}\left|g\left(x,y\right)\right|f\left(x,y\right)dxdy<\infty$$` se define la esperanza de la función `\(g(X,Y)\)` como: .resalta[ `$$\Large{E\left[g\left(X,Y\right)\right]=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}g\left(x,y\right)\cdot f\left(x,y\right)dxdy}$$` ] --- ### .blue[Ejemplo:] Sea `\((X,Y)\)` un vector aleatorio con función de densidad: `$$f(x,y)=\frac{6}{5}(x+y^{2}),\;\; 0\le x\le 1;\;\; 0\le y\le 1$$` Calcular `\(E[XY]\)` -- `$$E\left[XY\right]=\int_{0}^{1}\int_{0}^{1}xyf(x,y)dxdy=\int_{0}^{1}\int_{0}^{1}xy\frac{6}{5}(x+y^{2})dxdy=$$` -- `$$=\frac{6}{5}\left\{ \int_{0}^{1}\int_{0}^{1}x^{2}ydxdy+\int_{0}^{1}\int_{0}^{1}xy^{3}dxdy\right\} =$$` -- `$$\frac{6}{5}\left\{ \left[\frac{x^{3}}{3}\right]_{0}^{1}\left[\frac{y^{2}}{2}\right]_{0}^{1}+\left[\frac{x^{2}}{2}\right]_{0}^{1}\left[\frac{y^{4}}{4}\right]_{0}^{1}\right\}=$$` -- `$$=\frac{6}{5}\left\{ \frac{1}{3}\frac{1}{2}+\frac{1}{2}\frac{1}{4}\right\} =\frac{6}{5}\left(\frac{1}{6}+\frac{1}{8}\right)=\frac{1}{5}\left(1+\frac{6}{8}\right)=\frac{7}{20}$$` --- ## Primera propiedad de linealidad de la esperanza Ya hemos visto en el capítulo anterior que si `\(\lambda\)` es una constante y `\(X\)` una variable aleatoria, entonces: .resalta[ `$$\large{E\left[\lambda\cdot X\right]=\lambda\cdot E\left[X\right]}$$` ] --- ## Segunda propiedad de linealidad de la esperanza. -- .resalta[ `$$\large{E\left[X+Y\right]=E\left[X\right]+E\left[Y\right]}$$` ] -- #### .blue[Demostración: (Caso continuo)] -- `$$E\left[X+Y\right]=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}\left(x+y\right)f\left(x,y\right)dxdy=$$` -- `$$=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty} xf\left(x,y\right)dxdy+\int_{-\infty}^{\infty}\int_{-\infty}^{\infty} yf\left(x,y\right)dxdy=$$` -- `$$=\int_{-\infty}^{\infty} x\left\{ \int_{-\infty}^{\infty} f\left(x,y\right)dy\right\} dx+\int_{-\infty}^{\infty} y\left\{ \int_{-\infty}^{\infty} f\left(x,y\right)dx\right\} dy=$$` -- `$$\int_{-\infty}^{\infty} xf_{X}\left(x\right)dx+\int_{-\infty}^{\infty} yf_{Y}\left(y\right)dy=E\left[X\right]+E\left[Y\right]$$` -- <br> La demostración en el caso discreto es análoga, cambiando integrales por sumatorias. --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/stat/webEyPE/imagenes/darkGaussianBlur.jpg) background-size: cover class: inverse, center, middle # Asociación lineal entre variables aleatorias --- ## Asociación lineal entre variables aleatorias: .red[Covarianza] Sea `\((X,Y)\)` un vector aleatorio, y sean `\(\mu_{_X}=E[X]\)` y `\(\mu_{_Y}=E[Y]\)`. Se define la .red[ __Covarianza__] entre `\(X\)` e `\(Y\)` como: .resalta[ `$$\Large{\mathrm{Cov}(X,Y)=E[(X-\mu_{_X})(Y-\mu_{_Y})]}$$` ] -- La covarianza puede calcularse también mediante: .resalta[ `$$\Large{\textrm{Cov}(X,Y)=E[X\cdot Y]-E[X]\cdot E[Y]}$$` ] -- #### .blue[Demostración:] `$$\textrm{Cov}(X,Y)=E[(X-\mu_{_X})(Y-\mu_{_Y})]=E\left[XY-\mu_{_Y}X-\mu_{_X}Y+\mu_{_X}\mu_{_Y}\right]=$$` `$$=E[XY]-\mu_{_X}\mu_{_Y}-\mu_{_X}\mu_{_Y}+\mu_{_X}\mu_{_Y}=E[XY]-\mu_{_X}\mu_{_Y}$$` --- ### .blue[Ejemplo:] `$$f(x,y)=\frac{6}{5}(x+y^{2}),\;\; 0\le x\le 1;\;\; 0\le y\le 1$$` -- Tenemos que: `$$f_{X}\left(x\right)=\frac{6}{5}\left(x+\frac{1}{3}\right)\Longrightarrow E\left[X\right]=\frac{6}{5}\int_{0}^{1}x\left(x+\frac{1}{3}\right)dx=\frac{6}{5}\left[\frac{x^{3}}{3}+\frac{1}{3}\frac{x^{2}}{2}\right]_{0}^{1}=\frac{3}{5}$$` -- `$$f_{Y}\left(y\right)=\frac{6}{5}\left(\frac{1}{2}+y^{2}\right)\Longrightarrow E\left[Y\right]=\frac{6}{5}\int_{0}^{1}y\left(\frac{1}{2}+y^{2}\right)dy=\frac{6}{5}\left[\frac{1}{2}\frac{y^{2}}{2}+\frac{y^{4}}{4}\right]_{0}^{1}=\frac{3}{5}$$` -- <br> Por tanto: `$$\textrm{Cov}\left(X,Y\right)=E\left[XY\right]-E\left[X\right]E\left[Y\right]=\frac{7}{20}-\frac{3}{5}\cdot\frac{3}{5}=\frac{35-36}{100}=-\frac{1}{100}$$` --- ## Asociación lineal entre variables aleatorias: .red[Covarianza] ### .blue[Proposición:] .resalta[ Si `\(\large{X}\)` e `\(\large{Y}\)` son independientes `\(\Longrightarrow \large{\textrm{Cov}(X,Y)=0}\)` ] -- <br> #### .blue[Demostración:] Si `\(X\)` e `\(Y\)` son independientes, entonces `\(f\left(x,y\right)=f_{X}\left(x\right)f_{Y}\left(y\right)\)`, de donde: -- `$$E\left[XY\right]=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}xyf(x,y)dxdy=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}xyf_{X}\left(x\right)f_{Y}\left(y\right)dxdy=$$` `$$=\int_{-\infty}^{\infty}xf_{X}\left(x\right)dx\int_{-\infty}^{\infty}yf_{Y}\left(y\right)dy=E\left[X\right]E\left[Y\right]$$` y por tanto `\(E[XY]-E[X]E[Y]=0\)` --- ### .blue[Interpretación geométrica de la covarianza] .pull-left[  ] .pull-right[ <br> <img src="tema3-3_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-3-1.png" style="display: block; margin: auto;" /> ] -- * En los cuadrantes (2) y (3): `\((X-E[X])(Y-E[Y])\ge 0\)` -- * En los cuadrantes (1) y (4): `\((X-E[X])(Y-E[Y])\le 0\)` -- * Cuando entre `\(X\)` e `\(Y\)` hay una relación lineal .red[ __creciente__]: `\(\textrm{Cov}(X,Y) > 0\)` --- ### .blue[Interpretación geométrica de la covarianza] .pull-left[  ] .pull-right[ <br> <img src="tema3-3_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-5-1.png" style="display: block; margin: auto;" /> ] <br><br> * Cuando entre `\(X\)` e `\(Y\)` hay una relación lineal .red[ __decreciente__]: `\(\textrm{Cov}(X,Y) < 0\)` --- ### .blue[Interpretación geométrica de la covarianza] .pull-left[  ] .pull-right[ <br> <img src="tema3-3_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-7-1.png" style="display: block; margin: auto;" /> ] <br><br> * Cuando entre `\(X\)` e `\(Y\)` .red[ __no hay relación lineal__]: `\(\textrm{Cov}(X,Y) = 0\)` --- ## Asociación lineal entre variables aleatorias: .red[Correlación] Se define el .red[ __coeficiente de correlación lineal de Pearson__] como: .resalta[ `$$\Large{\rho_{_X,_Y}=\frac{\textrm{cov}\left(X,Y\right)}{\sigma_{_X}\sigma_{_Y}}}$$` ] siendo `\(\sigma_{X}^{2}\)` y `\(\sigma_{Y}^{2}\)` las varianzas de `\(X\)` e `\(Y\)` respectivamente. --- ### .blue[Ejemplos:] <!-- --> --- ### .blue[Propiedades del coeficiente de correlación] * El coeficiente de correlación mide el grado de asociación lineal entre `\(X\)` e `\(Y\)`: .resalta[ `$$\Large{-1 \le \rho_{_X,_Y} \le 1}$$` ] Cuanto más se aproxima `\(|\rho_{_X,_Y}|\)` a 1, más se aproxima la relación entre `\(X\)` e `\(Y\)` a una recta. <br> -- .resalta[ * Si `\(|\rho_{_X,_Y}| = 1\)` entonces `\(Y = aX + b\)`, esto es, los valores `\((X,Y)\)` se disponen __exactamente__ a lo largo de una recta. ] -- <br> [Pinchar aquí para ver la demostración de estas propiedades](Demostraciones.html#covacor) --- ### .blue[Propiedades del coeficiente de correlación] <br> * Dos variables aleatorias `\(X\)` e `\(Y\)` se dicen .red[ __incorreladas__] si `\(\textrm{Cor}(X,Y)=0\)` -- <br> * Ya hemos visto que si `\(X\)` e `\(Y\)` son independientes, entonces `\(\textrm{Cov}(X,Y)=0\)`, y por tanto también `\(\textrm{Cor}(X,Y)=0\)` (son incorreladas) -- <br> * Lo contrario no es cierto, es decir, si `\(X\)` e `\(Y\)` son .red[ __incorreladas, no son necesariamente independientes__]. -- <br> Veamos a continuación un ejemplo de variables incorreladas, pero dependientes. --- ### .blue[Ejemplo:] Sea `\((X,Y)\)` un vector aleatorio con función de densidad: `$$f(x,y) = \frac{3}{4},\;\;\; -1\le x \le 1; \;\; 0\le y \le (1-x^2)$$` .pull-left[  ] .pull-right[ <br> <img src="tema3-3_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-10-1.png" style="display: block; margin: auto;" /> ] --- ### .blue[Ejemplo:] * La densidad marginal de `\(X\)` es: -- `$$f_{X}\left(x\right)=\int_{-\infty}^{\infty}f\left(x,y\right)dy=\int_{0}^{1-x^{2}}\frac{3}{4}dy=\frac{3}{4}\left[y\right]_{0}^{1-x^{2}}=\frac{3}{4}\left(1-x^{2}\right)$$` -- * La densidad marginal de `\(Y\)` es: -- `$$f_{Y}\left(y\right)=\int_{-\infty}^{\infty}f\left(x,y\right)dx=\int_{-\sqrt{1-y}}^{\sqrt{1-y}}\frac{3}{4}dx=\frac{3}{4}\left[x\right]_{-\sqrt{1-y}}^{\sqrt{1-y}}=\frac{3}{2}\sqrt{1-y};\,\,\,0\le y\le1$$` -- <br> * Obviamente `\(f(x,y)\neq f_X(x)\cdot f_Y(y)\Longrightarrow\)` `\(X\)` e `\(Y\)` __no son independientes__. --- ### .blue[Ejemplo:] Ahora, para calcular la correlación entre `\(X\)` en `\(Y\)` hallamos `\(E[X]\)`, `\(E[Y]\)` y `\(E[XY]\)`: -- `$$E\left[X\right]=\int_{-\infty}^{\infty}xf_{X}\left(x\right)dx=\int_{-1}^{1}\frac{3}{4}x\left(1-x^{2}\right)dx=\frac{3}{4}\left[\frac{x^{2}}{2}-\frac{x^{4}}{4}\right]_{-1}^{1}=0$$` -- `$$E\left[Y\right]=\int_{-\infty}^{\infty}yf_{Y}\left(y\right)dy=\int_{0}^{1}\frac{3}{2}y\sqrt{1-y}dy=...=\frac{2}{5}$$` <font size="2" color="red"> (Esta integral se resuelve fácilmente con el cambio de variable `1-y=t^2`) </font> -- `$$E\left[XY\right]=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}xy\cdot f\left(x,y\right)dy=\int_{-1}^{1}\int_{0}^{1-x^{2}}\frac{3}{4}dydx=\frac{3}{4}\int_{-1}^{1}x\left[y\right]_{0}^{1-x^{2}}dx$$` `$$=\frac{3}{4}\int_{-1}^{1}x\left(1-x^{2}\right)dx=\frac{3}{4}\left[\frac{x^{2}}{2}-\frac{x^{4}}{4}\right]=0$$` -- Por tanto: `$$\textrm{Cor}(X,Y)=E[XY]-E[X]E[Y]=0$$` lo que implica que `\(X\)` e `\(Y\)` son __variables incorreladas__ --- ## Varianza de la suma de variables aleatorias. .resalta[ Si `\(X\)` e `\(Y\)` son variables aleatorias __independientes__ o __incorreladas__: `$$\Large{\textrm{Var}(X+Y)=\textrm{Var}(X)+\textrm{Var}(Y)}$$` ] -- #### .blue[Demostración:] Llamando `\(\mu_{_X}=E\left[X\right]\)` y `\(\mu_{_Y}=E\left[Y\right]\)` y teniendo en cuenta que `\(E\left[X+Y\right]=\mu_{X}+\mu_{Y}\)`: `$$\textrm{Var}\left(X+Y\right)=E\left[\left(X+Y-\left(\mu_{X}+\mu_{Y}\right)\right)^{2}\right]=E\left[\left(\left(X-\mu_{X}\right)+\left(Y-\mu_{Y}\right)\right)^{2}\right]=$$` -- `$$=E\left[\left(X-\mu_{X}\right)^{2}+2\left(X-\mu_{X}\right)\left(Y-\mu_{Y}\right)+\left(Y-\mu_{Y}\right)^{2}\right]=$$` -- `$$=E\left[\left(X-\mu_{X}\right)^{2}\right]+2E\left[\left(X-\mu_{X}\right)\left(Y-\mu_{Y}\right)\right]+E\left[\left(Y-\mu_{Y}\right)^{2}\right]=$$` -- `$$=\textrm{Var}(X) + \textrm{Var}(Y) +2\cdot \textrm{Cov}(X,Y)=\textrm{Var}(X) + \textrm{Var}(Y)$$` pues `\(\textrm{Cov}(X,Y)=0\)` cuando `\(X\)` e `\(Y\)` son independientes o correladas. --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/asp/descargas/azar.jpg) background-size: cover background-position: 15% 45% class: inverse, top, left # 6. Distribuciones multivariantes generales --- ## Distribución conjunta de un vector aleatorio Todas las definiciones y propiedades que hemos visto para las distribuciones de probabilidad de vectores aleatorios bidimensionales `\(\large{(X,Y)}\)` se pueden generalizar al caso de vectores multivariantes: -- * Si `\(\left(X_{1},\ldots,X_{n}\right)\)` es un vector de variables aleatorias, su .red[ __distribución de probabilidad acumulativa conjunta__] se define como: .resalta[ `$$\Large{F\left(x_{1},\ldots,x_{n}\right)=\Pr\left(X_{1}\leq x_{1},\ldots,X_{n}\leq x_{n}\right)}$$` ] -- <br> * La .red[ __distribución marginal__] de `\(X_k\)` se obtiene como: `$$\Large{F_k(x_k)=\Pr(X_k\le x_k)=F(\infty,\dots,x_k,\dots,\infty)}$$` --- ## Distribución conjunta de un vector aleatorio * Cuando las `\(\large{X_i}\)` son continuas, la distribución de probabilidad de `\(\left(X_{1},\ldots,X_{n}\right)\)` se dice .red[ __absolutamente continua__] si existe una función `\(f\left(x_{1},\ldots,x_{n}\right)\geq0\)` tal que: `$$\Large{F\left(t_{1},\ldots,t_{n}\right)=\int_{-\infty}^{t_{1}}\ldots\int_{-\infty}^{t_{n}}f\left(x_{1},\ldots,x_{n}\right)dx_{1}\cdots dx_{n}}$$` -- <br> * En tal caso, la función `\(f\left(x_{1},\ldots,x_{n}\right)\)` recibe el nombre de .red[ __función de densidad de probabilidad conjunta__]. -- <br> * Cuando las `\(\large{X_i}\)` son discretas, la .red[ __función de probabilidad conjunta__] del vector `\(\left(X_{1},\ldots,X_{n}\right)\)` es: `$$\Large{\Pr(X_1=x_1, \dots, X_n=x_n)}$$` --- ## Independencia multivariante Las variables aleatorias `\(X_{1},\ldots,X_{n}\)`, con distribución conjunta `\(F\left(t_{1},\ldots,t_{n}\right)\)` son .red[ __independientes__] si se satisface a condición: .resalta[ `$$\large{F\left(t_{1},\ldots,t_{n}\right)=F_{1}\left(t_{1}\right)\cdot\cdots\cdot F_{n}\left(t_{n}\right)\,\,:\,\,\forall t_{1},\ldots,t_{n}}$$` ] -- Esta condición es equivalente a: * En el caso discreto `$$\large{\Pr(X_1=x_1,\dots, X_n=x_n)=\Pr(X_1=x_1)\dots\Pr(X_n=x_n)}$$` -- <br> * En el caso continuo: `$$\large{f\left(x_{1},\ldots,x_{n}\right)=f_{1}\left(x_{1}\right)\cdots f_{n}\left(x_{n}\right)}$$` (siendo `\(f\)` la densidad conjunta, y `\(f_{i}\)` la densidad de probabilidad marginal de la variable `\(X_{i}\)`) --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/asp/descargas/azar.jpg) background-size: cover background-position: 15% 45% class: inverse, top, left # 7. Sucesiones de variables aleatorias independientes --- ## Sucesiones de variables aleatorias independientes ### .blue[Ejemplo] * Consideremos un sistema electrónico compuesto por una única placa de microcircuitos tal que cuando la placa falla es sustituída por otra placa análoga. -- * Sea `\(X_k\)` la duración de la `\(k\)`-ésima placa que se instala en el sistema. -- * La duración de cada placa es una variable aleatoria; como las sucesivas placas son siempre iguales, sus duraciones tienen .blue[la misma función de densidad] `\(f(x)\)`. -- * Asimismo, es razonable suponer que las duración de cada placa es .blue[independiente] del tiempo que hayan durado las demás. -- * Diremos en este caso que `\(X_1, X_2, \dots, X_n\)` constituye una .red[ __sucesión de variables aleatorias independientes e idénticamente distribuídas (iid)__] --- ## Sucesiones de variables aleatorias independientes ### .blue[Otros ejemplos] * Tiempos entre llegadas de paquetes a un conmutador de red. -- * Tamaño de los sucesivos paquetes de datos recibidos en un conmutador. -- * Número de llamadas de telefonía móvil atendidas por una antena cada día. -- * Duraciones de las sucesivas llamadas telefónicas atendidas por una antena de telefonía móvil. -- * Tamaño de los sucesivos paquetes de datos que transmite un jugador durante una partida de un juego en red. -- * Tiempos de espera de un paquete en los sucesivos nodos de la red que debe atravesar para llegar de su origen a su destino. --- ## Sucesiones de variables aleatorias independientes .resalta[ .blue[ __Teorema:__] Sea `\(X_1,X_2,\dots,X_n\)` una sucesión de variables aleatorias independientes e idénticamente distribuidas tales que `\(E[X_k]=\mu\)` y `\(\textrm{Var}(X_k)=\sigma^2\)` para `\(k=1,2,\dots,n\)`. Entonces, si `\(\hat{\mu}_n=\frac{1}{n}\sum_{i=1}^{n}X_{i}\)` se tiene que: `$$E\left[\left(\hat{\mu}_{n}-\mu\right)^{2}\right]\underset{n\rightarrow\infty}{\longrightarrow}0$$` ] -- <br> Este teorema indica que si se dispone de una muestra de _n_ observaciones de `\(X_i\)`, a medida que la muestra aumenta de tamaño (_n_ crece) la media aritmética de dichas observaciones `\(\hat{\mu}_n\)` se va aproximando en promedio cada vez más al valor de `\(\mu\)`. Dicho de otra manera: La esperanza `\(\mu\)` de una variable aleatoria coincide con la media de un número grande de observaciones independientes de dicha variable. --- ### .blue[Demostración] -- * Por las propiedades de linealidad de la esperanza: `$$E\left[\hat{\mu}_{n}\right]=E\left[\frac{1}{n}\sum_{i=1}^{n}X_{i}\right]=\frac{1}{n}\sum_{i=1}^{n}E\left[X_{i}\right]=\mu$$` -- * Por ser las `\(X_i\)` variables independientes: `$$\textrm{Var}\left(\hat{\mu}_{n}\right)=\textrm{var}\left(\frac{1}{n}\sum_{i=1}^{n}X_{i}\right)=\frac{1}{n^{2}}\sum_{i=1}^{n}\textrm{var}\left(X_{i}\right)=\frac{\sigma^{2}}{n}$$` -- * Ahora bien: `$$E\left[\left(\hat{\mu}_{n}-\mu\right)^{2}\right]=E\left[\left(\hat{\mu}_{n}-E\left[\hat{\mu}_{n}\right]\right)^{2}\right]=\textrm{Var}\left(\hat{\mu}_{n}\right)=\frac{\sigma^{2}}{n}\underset{n\rightarrow\infty}{\longrightarrow}0$$` --- ## Sucesiones de variables aleatorias independientes Si `\(X_1,\dots,X_n\)` son variables aleatorias i.i.d. con esperanza `\(\mu\)` y varianza `\(\sigma^2\)`, entonces: 1. `\(E\left[\sum_{i=1}^{n}X_{i}\right]=n\mu\)` 2. `\(\textrm{var}\left(\sum_{i=1}^{n}X_{i}\right)=n\sigma^2\)` Si además `\(n\rightarrow\infty\)`: -- .resalta[ .blue[ __Teorema del límite central:__] Sea `\(X_1,X_2,\dots,X_n\)` una sucesión de variables aleatorias independientes e idénticamente distribuidas tales que `\(E[X_k]=\mu\)` y `\(\textrm{Var}(X_k)=\sigma^2\)` para `\(k=1,2,\dots,n\)`. Entonces: `$$\frac{\sum_{i=1}^{n}X_{i}-n\mu}{\sigma\sqrt{n}}\overset{_{d}}{\longrightarrow}N\left(0,1\right)$$` ] --- ### .blue[Ejemplo] Un sistema electrónico está compuesto por una única placa de microcircuitos. Cuando la placa falla, se sustituye por otra igual. Si la duración de cada placa sigue una distribución exponencial con parámetro `\(\mu=5\)` meses, y se dispone de 30 placas que se van reemplazando sucesivamente a medida que fallan ¿Cuál es la probabilidad de que el sistema funcione durante al menos 10 años? -- Sea `\(X_i\)` la duración de la `\(i\)`-ésima placa, `\(X_i\approx exp(5)\)`. Por tanto: `$$E[X_i]=\mu=5,\hspace{4em}\sigma^2=\textrm{Var}(X)=\mu^2=25$$` -- La duración total de las 30 placas es `\(\sum_{i=1}^{n}X_{i}\)`. De acuerdo con el teorema del límite central: `$$\frac{\sum_{i=1}^{30}X_{i}-30\cdot 5}{5\sqrt{30}}=\frac{\sum_{i=1}^{30}X_{i}-150}{5\sqrt{30}}\approx N\left(0,1\right)$$` -- La probabilidad de que la duración total supere los 10 años (120 meses) es entonces: -- `$$\Pr\left(\sum_{i=1}^{30}X_{i}\ge120\right)=\Pr\left(\frac{\sum_{i=1}^{30}X_{i}-150}{5\sqrt{30}}\ge\frac{120-150}{5\sqrt{30}}\right)=\Pr\left(Z\ge-1.09\right)=0.86214$$` --- ### .blue[Ejemplo] En el sistema anterior ¿De cuántas placas debe disponer el sistema si se quiere garantizar que la probabilidad de que dure más de 15 años sea al menos 0.99? -- 15 años son 180 meses; debemos encontrar el valor de _n_ tal que: `$$\Pr\left(\sum_{i=1}^{n}X_{i}\ge180\right)\ge 0.99$$` -- Entonces: `$$\Pr\left(\sum_{i=1}^{n}X_{i}\ge180\right)=\Pr\left(\frac{\sum_{i=1}^{n}X_{i}-5n}{5\sqrt{n}}\ge\frac{180-5n}{5\sqrt{n}}\right)=\Pr\left(Z\ge\frac{180-5n}{5\sqrt{n}}\right)=0.99$$` -- Utilizando la tabla de la `\(N(0,1)\)` se observa que `\(\Pr\left(Z\ge -2.33\right)=0.99\)`. Por tanto: -- `$$\frac{180-5n}{5\sqrt{n}}=-2.33$$` -- Despejando _n_: `$$\left(180-5n\right)^{2}=\left(-2.33\cdot5\sqrt{n}\right)^{2}\Rightarrow180^{2}-1800n+25n^{2}=135.7225n\Rightarrow$$` -- `$$25n^{2}-1935.7225n+180^{2}=0\Rightarrow n=53$$` --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/asp/descargas/azar.jpg) background-size: cover background-position: 15% 45% class: inverse, top, left # 8. Función característica multivariante --- # Función característica multivariante Sea `\((X,Y)\)` un vector aleatorio. Se define su .red[ __función característica__] como: .resalta[ `$$\Large{\varphi(u,v) = E[e^{i\left(uX+vY\right)}]}$$` ] -- ### .blue[Propiedades] -- * La función característica de la distribución marginal de `\(X\)` es: `$$\varphi_{_X}(u)=E[e^{iuX}]=\varphi(u,0)$$` -- * La función característica de la distribución marginal de `\(Y\)` es: `$$\varphi_{_Y}(v)=E[e^{ivY}]=\varphi(0,v)$$` --- ### .blue[Propiedades de la Función característica multivariante] * Si `\(X\)` e `\(Y\)` son independientes: .resalta[ `$$\Large{\varphi(u,v) = \varphi_{_X}(u)\cdot\varphi_{_Y}(v)}$$` ] -- <br> #### .blue[Demostración (caso continuo):] `$$\varphi\left(u,v\right)=E\left[e^{i\left(uX+vY\right)}\right]=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}e^{i\left(ux+vy\right)}f\left(x,y\right)dxdy=$$` -- `$$=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}e^{i\left(ux+vy\right)}f_{X}\left(x\right)f_{Y}\left(y\right)dxdy=\left(\int_{-\infty}^{\infty}e^{iux}f_{X}\left(x\right)dx\right)\left(\int_{-\infty}^{\infty}e^{ivy}f_{Y}\left(y\right)dy\right)=$$` -- `$$=\varphi_{_X}\left(u\right)\varphi_{_Y}\left(v\right)$$` <br> La demostración para el caso discreto es análoga cambiando integrales por sumas y función de densidad por función de probabilidad. --- ### .blue[Propiedades de la Función característica multivariante] * Si `\(X\)` e `\(Y\)` son independientes, la función característica de su suma `\(T=X+Y\)` es: .resalta[ `$$\Large{\varphi_{_T}(t) = \varphi_{_X}(t)\cdot\varphi_{_Y}(t)}$$` ] -- <br> #### .blue[Demostración:] `$$\varphi_{_{T}}\left(t\right)=E\left[e^{itT}\right]=E\left[e^{it\left(X+Y\right)}\right]=E\left[e^{i\left(tX+tY\right)}\right]=\varphi\left(t,t\right)=\varphi_{_X}\left(t\right)\varphi_{_Y}\left(t\right)$$` --- ### .blue[Propiedades de la Función característica multivariante] Esta propiedad se puede generalizar fácilmente para la función característica de la suma de `\(n\)` variables aleatorias independientes: .resalta[ `$$\Large{\varphi_{_{X_1+X_2+\dots+X_n}}(t) = \prod_{i=1}^{n}\varphi_{_{X_{i}}}\left(t\right)}$$` ] -- <br> A partir de esta propiedad, utilizando el teorema de inversión de la función característica, es posible hallar la función de densidad de la suma de variables aleatorias independientes. [Véase aquí un ejemplo](ejemplosDesarrollados.html#erlang)