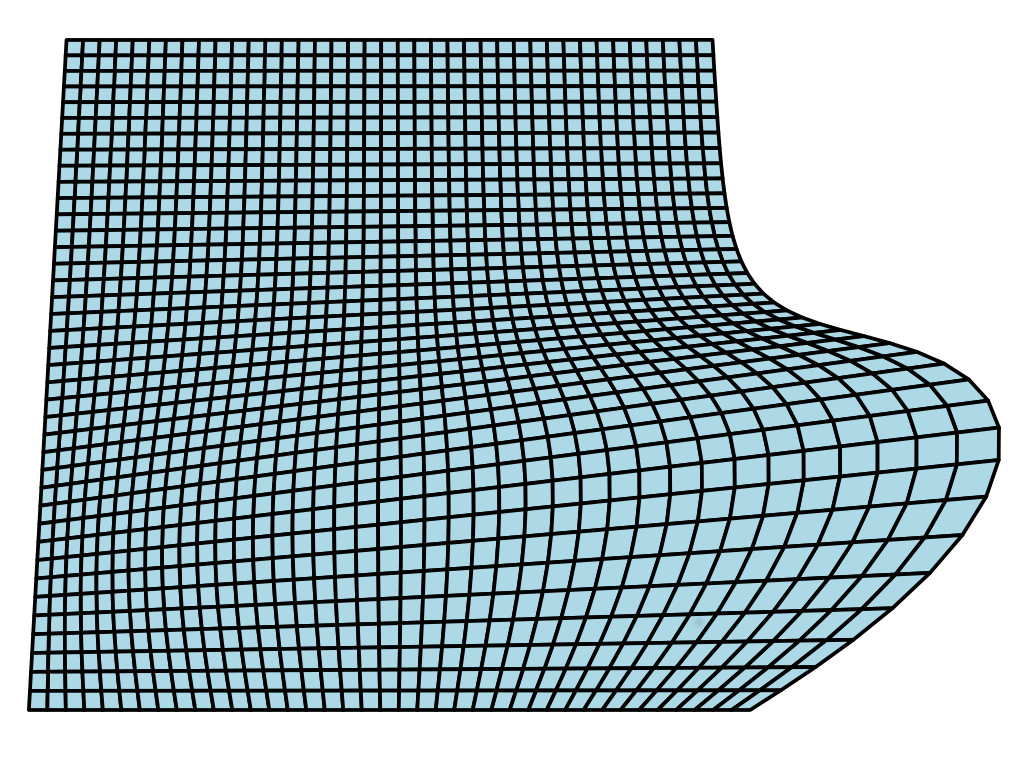

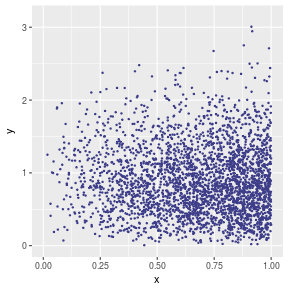

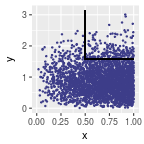

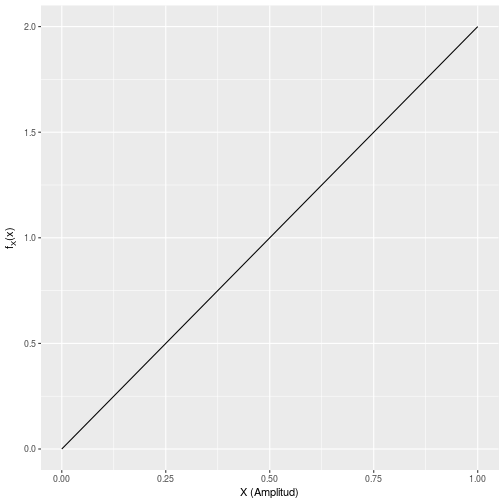

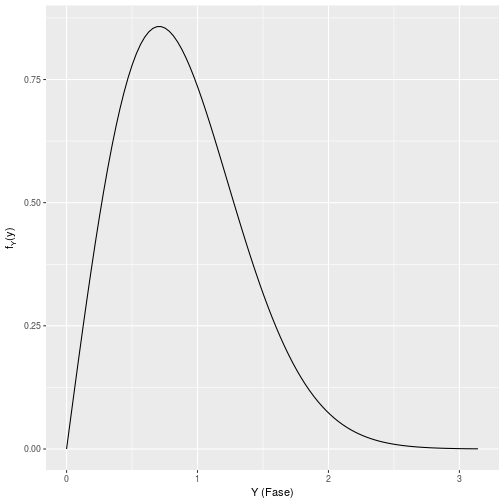

class: center, middle, inverse, title-slide # Estadística y Procesos Estocásticos <br> Tema 3: Distribuciones Multivariantes ### <br><br><br><br><br><br><br>Grado en Ingeniería en Tecnologías de la Telecomunicación --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/asp/descargas/azar.jpg) background-size: cover background-position: 15% 45% class: inverse, top, left # 3. Distribución conjunta de dos Variables Aleatorias Continuas. --- ## Distribución conjunta de dos Variables Aleatorias Continuas. Dadas dos variables aleatorias X e Y definidas sobre un mismo espacio de probabilidad `\(\left(\Omega,\mathcal{F},P\right)\)`, la .red[ __función de distribución conjunta__] de `\(\left(X,Y\right)\)` es: .resalta[ `$$\large{F\left(s,t\right)=\Pr\left(X\leq s,Y\leq t\right)=\Pr\left(\left\{ X\leq s\right\} \cap\left\{ Y\leq t\right\} \right)}$$` ] <br> -- En el caso de que `\(X\)` e `\(Y\)` sean continuas, si existe una función `\(f:\mathbb{R}^{2}\rightarrow\mathbb{R}\)`, __integrable__ y __no negativa__, tal que: `$$\Large{F\left(s,t\right)=\int_{-\infty}^{s}\int_{-\infty}^{t}f\left(x,y\right)dxdy}$$` entonces la función de distribución `\(F(s,t)\)` es __absolutamente continua__ y `\(f(s,t)\)` recibe el nombre de .red[ __función de densidad de probabilidad__] del vector `\((X,Y)\)`. --- ## Propiedades de la función de densidad bivariante <br> -- `$$\Large{\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}f\left(x,y\right)dxdy=1}$$` -- <br> `$$\Large{\Pr\left(a<X\leq b,c<Y\leq d\right)=\int_{a}^{b}\int_{c}^{d}f\left(x,y\right)dxdy}$$` -- <br> Si `\(f(x,y)\)` es continua, `$$\Large{\frac{\partial^{2}}{\partial x\partial y}F\left(x,y\right)=f\left(x,y\right)}$$` --- ### .blue[Ejemplo:] En estudios sobre la actividad neurológica del cerebro es habitual medir señales eléctricas en la corteza cerebral. En ausencia de estímulos externos, la señal medida en cierta región tiene una amplitud `\(X\)` y una fase `\(Y\)` aleatorias que se distribuyen de acuerdo a la función de densidad: `$$\large{f\left(x,y\right)=\lambda xye^{-y^{2}},\,\,0\le x\le1,\,\,\,0\le y\le\pi}$$` -- 1. Determinar el valor de `\(\lambda\)` para que la función anterior esté bien definida. -- 2. Determinar la probabilidad de que la señal registrada tenga una amplitud mayor que 0.5 y una fase entre `\(\pi/2\)` y `\(\pi\)`. --- ### .blue[Ejemplo:] __1.__ El valor de la integral de la función de densidad sobre el rango en que están definidas las variables debe ser 1. Por tanto: `$$\large{1=\int_{-\infty}^{\infty}\int_{-\infty}^{\infty}f\left(x,y\right)dxdy=\int_{0}^{1}\int_{0}^{\pi}\lambda xye^{-y^{2}}dxdy=}$$` -- `$$=\large{\lambda\int_{0}^{1}x\left\{ \int_{0}^{\pi}ye^{-y^{2}}dy\right\} dx=\lambda\int_{0}^{1}x\left[-\frac{1}{2}e^{-y^{2}}\right]_{0}^{\pi}dx=}$$` -- `$$\large{=-\frac{\lambda}{2}\left(e^{-\pi^{2}}-1\right)\left[\frac{x^{2}}{2}\right]_{0}^{1}=\frac{\lambda\left(1-e^{-\pi^{2}}\right)}{4}\,\,\,\Longrightarrow\,\,\lambda=\frac{4}{1-e^{-\pi^{2}}}}$$` -- <br><br> La figura siguiente muestra la representación gráfica de esta función de densidad: --- `$$\large{f\left(x,y\right)=\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}}$$` <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-1-1.png" style="display: block; margin: auto;" /> [Pulsar aquí para rotar esta figura de forma interactiva](sup3DInteractiva.html) --- A continuación se muestra la función de densidad `\(f(x,y)\)` vista "desde arriba", así como una muestra aleatoria de 5000 observaciones (puntos) de la variable aleatoria bidimensional `\((X,Y)\)`; puede verse que: * la densidad (observada) de puntos es mayor donde la densidad de probabilidad (teórica) es más alta. * donde la densidad de probabilidad es cero, no hay observaciones de `\((X,Y)\)` .pull-left[  ] .pull-right[ <!-- --> ] --- ### .blue[Ejemplo:] __2.__ Determinar la probabilidad de que la señal registrada tenga una fase entre `\(\pi/2\)` y `\(\pi\)` y una amplitud mayor que 0.5. <br> -- `$$P\left(X>0.5,\frac{\pi}{2}\le Y\le\pi\right)=\frac{4}{1-e^{-\pi^{2}}}\int_{0.5}^{1}\int_{\pi/2}^{\pi}xye^{-y^{2}}dxdy=$$` -- `$$\frac{4}{1-e^{-\pi^{2}}}\int_{0.5}^{1}x\left[-\frac{1}{2}e^{-y^{2}}\right]_{\pi/2}^{\pi}dx=\frac{2}{1-e^{-\pi^{2}}}\int_{0.5}^{1}x\left(e^{-\left(\pi/2\right)^{2}}-e^{-\pi^{2}}\right)dx=$$` -- `$$\frac{2}{1-e^{-\pi^{2}}}\left(e^{-\left(\pi/2\right)^{2}}-e^{-\pi^{2}}\right)\left[\frac{x^{2}}{2}\right]_{1/2}^{1}=\frac{2}{1-e^{-\pi^{2}}}\left(e^{-\left(\pi/2\right)^{2}}-e^{-\pi^{2}}\right)\left(\frac{1}{2}-\frac{1}{8}\right)=0.0636$$` -- <br> Esta probabilidad corresponde al volumen bajo la función de densidad sobre la región `\(0.5\le X\le 1\)`, `\(\frac{\pi}{2}\le Y\le \pi\)`, tal como se muestra en la figura siguiente: --- <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-4-1.png" style="display: block; margin: auto;" /> -- class: split-25 .column[ <!-- --> ] .column[ <br><br> La proporción (observada) de puntos de la muestra anterior que caen en la región `\(0.5\le X\le 1\)`, `\(\frac{\pi}{2}\le Y\le \pi\)` es 0.06867, que se aproxima bastante al valor teórico 0.0636. ] --- ## Función de densidad marginal Si `\(f(x,y)\)` es la función de densidad del vector aleatorio `\((X,Y)\)`, la .red[ __función de densidad marginal de X__] se obtiene integrando (sumando) sobre todos los posibles valores de `\(\large{y}\)`: .resalta[ `$$\Large{f_{X}\left(x\right)=\int_{-\infty}^{\infty}f\left(x,y\right)dy}$$` ] -- <br> Análogamente, la .red[ __densidad marginal de Y__] se obtiene integrando (sumando) sobre todos los posibles valores de `\(\large{x}\)`: .resalta[ `$$\Large{f_{Y}\left(y\right)=\int_{-\infty}^{\infty}f\left(x,y\right)dx}$$` ] --- ### .blue[Ejemplo:] Calculemos las densidades marginales de: `$$\large{f\left(x,y\right)=\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}}$$` -- __1.__ .blue[Densidad marginal de _X_]: -- `$$f_{X}\left(x\right)=\int_{-\infty}^{\infty}f\left(x,y\right)dy=\int_{0}^{\pi}\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}dy=\frac{4x}{1-e^{-\pi^{2}}}\int_{0}^{\pi}ye^{-y^{2}}dy=$$` -- `$$=\frac{4x}{1-e^{-\pi^{2}}}\left[-\frac{1}{2}e^{-y^{2}}\right]_{0}^{\pi}=\frac{4x}{1-e^{-\pi^{2}}}\frac{1}{2}\left(1-e^{-\pi^{2}}\right)=2x$$` -- <br> __2.__ .blue[Densidad marginal de _Y_:] -- `$$f_{Y}\left(y\right)=\int_{-\infty}^{\infty}f\left(x,y\right)dx=\int_{0}^{1}\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}dx=\frac{4ye^{-y^{2}}}{1-e^{-\pi^{2}}}\int_{0}^{1}xdx=$$` -- `$$=\frac{4ye^{-y^{2}}}{1-e^{-\pi^{2}}}\left[\frac{x^{2}}{2}\right]_{0}^{1}=\frac{4ye^{-y^{2}}}{1-e^{-\pi^{2}}}\frac{1}{2}=\frac{2ye^{-y^{2}}}{1-e^{-\pi^{2}}}$$` --- ### .blue[Ejemplo:] Gráficamente: .pull-left[ `\(f_X(x)=2x\)` <!-- --> ] .pull-right[ `\(f_Y(y)=\frac{2ye^{-y^{2}}}{1-e^{-\pi^{2}}}\)` <!-- --> ] --- ## Distribuciones de probabilidad condicionales. La función de distribución acumulativa de `\(Y\)` condicionada por el valor de `\(X\)` se define como: .resalta[ `$$\Large{F_{Y|X=x}\left(y\right)=\Pr\left(Y\leq y\mid X=x\right)}$$` ] <br> -- En el caso discreto: `$$F_{Y|X=x}\left(t\right)=\Pr\left(Y\leq t\mid X=x\right)=\frac{P\left(Y\le t,X=x\right)}{P\left(X=x\right)}=\sum_{y\le t}\frac{P\left(Y=y,X=x\right)}{P\left(X=x\right)}$$` -- En el caso continuo sustituimos la suma por la integral (siempre que exista `\(f(x,y)\)`): `$$F_{Y|X=x}\left(t\right)=\Pr\left(Y\leq t\mid X=x\right)=\int_{-\infty}^{t}\frac{f\left(x,y\right)}{f_{X}\left(x\right)}dy$$` --- ## Distribuciones de probabilidad condicionales. Derivando en la función de distribución condicionada, se obtiene la .red[ __función de densidad de__] `\(Y\)` .red[ __condicionada por__] `\(X\)`: .resalta[ `$$\Large{f_{Y|X}\left(y|x\right)=\frac{f\left(x,y\right)}{f_{X}\left(x\right)}}$$` ] -- <br> Análogamente, la .red[ __función de densidad de__] `\(X\)` .red[ __condicionada por__] `\(Y\)` es: .resalta[ `$$\Large{f_{X|Y}\left(x|y\right)=\frac{f\left(x,y\right)}{f_{Y}\left(y\right)}}$$` ] --- ### .blue[Ejemplo:] `$$\large{f\left(x,y\right)=\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}}$$` -- __1.__ .blue[Densidad condicional de _X_ dado el valor de _Y_]: -- `$$f_{X|Y}\left(x|y\right)=\frac{f\left(x,y\right)}{f_{Y}(y)}=\frac{\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}}{\frac{2ye^{-y^{2}}}{1-e^{-\pi^{2}}}}=2x$$` -- __2.__ .blue[Densidad condicional de _Y_ dado el valor de _X_:] -- `$$f_{Y|X}\left(y|x\right)=\frac{f\left(x,y\right)}{f_{X}(x)}=\frac{\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}}{2x}=\frac{2ye^{-y^{2}}}{1-e^{-\pi^{2}}}$$` -- Nótese en este ejemplo que: -- * .red[Las densidades condicionales coinciden con las marginales (ésto no tiene por qué ocurrir siempre)] -- * .red[La densidad de X condicionada por Y no depende de Y, y la densidad de Y condicionada por X no depende de X. (ésto tampoco ocurre siempre)] --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/asp/descargas/azar.jpg) background-size: cover background-position: 15% 45% class: inverse, top, left # 4. Independencia de Variables Aleatorias --- ## Independencia de variables aleatorias. Dados dos sucesos `\(A\)` y `\(B\)` de un espacio muestral `\(\Omega\)`, ya habíamos visto que son .red[ __independientes__] si `\(B\)` __no informa__ sobre `\(A\)`, esto es: `$$P(A|B)=P(A)$$` De donde se seguía que si `\(A\)` y `\(B\)` son independientes, entonces: `$$P(A\cap B)=P(A)\cdot P(B)$$` -- De modo completamente análogo, dado un vector `\((X,Y)\)` de variables aleatorias, ambas son .red[ __independientes__] si: * En el caso discreto: .resalta[ `$$\large{P(X=x |Y=y) =P(X=x) \hspace{2em} P(X=x,Y=y)=P(X=x)P(Y=y)}$$` ] -- * En el caso continuo: .resalta[ `$$\large {f_{Y|X}(y/x)=f_Y(y) \hspace{8em} f(x,y)=f_X(x)f_Y(y)}$$` ] --- ## Independencia de variables aleatorias. * La independencia entre dos variables aleatorias `\(X\)` e `\(Y\)` significa que el conocimiento del valor de una de ellas no permite mejorar las predicciones que podamos hacer sobre el valor de la otra. -- * En el ejemplo anterior, `\(f_{X|Y}(x|y) = 2x\)`, lo que significa que la densidad de `\(X\)` conociendo el valor de `\(Y\)` no depende de `\(Y\)`; por tanto `\(Y\)` no informa sobre `\(X\)`. -- * Lo mismo puede decirse sobre la densidad de `\(Y\)` conocido el valor de `\(X\)`, en este caso `\(f_{Y|X}\left(y|x\right)=\frac{2ye^{-y^{2}}}{1-e^{-\pi^{2}}}\)`: no depende de `\(X\)` y por tanto el valor de `\(X\)` no informa sobre la probabilidad de `\(Y\)`. -- * Podemos comprobar en este caso que se cumple que `\(f(x,y)=f_X(x)f_Y(y)\)`, pues `\(\frac{4xye^{-y^{2}}}{1-e^{-\pi^{2}}}=2x\cdot \frac{2ye^{-y^{2}}}{1-e^{-\pi^{2}}}\)` -- * Por tanto nuestras variables `\(X\)` e `\(Y\)` (amplitud y fase de una señal medida en un cerebro en reposo) __son independientes__. --- ## Esperanza condicional. Dado un vector aleatorio `\((X,Y)\)`, la .red[ __esperanza de__ ] `\(\large{Y}\)` .red[ __condicionada por__] `\(\large{X}\)` es el valor esperado de `\(\large{Y}\)` cuando la `\(\large{X}\)` toma un valor fijo `\(\large{x}\)`. Se calcula mediante: -- <br> * Cuando `\(X\)` es discreta: .resalta[ `$$\Large{E\left[Y\mid X=x\right]=\sum_{y}yP\left(Y=y\mid X=x\right)}$$` ] -- * Cuando `\(X\)` es continua: .resalta[ `$$\Large{E\left[Y\mid X=x\right]=\int_{-\infty}^{\infty}yf\left(y\mid x\right)dy}$$` ] -- <br> La esperanza de `\(X\)` condicionada por `\(Y\)` se define de modo análogo. --- ### .blue[Ejemplo 1:] `$$\large{f\left(x,y\right)=\frac{4}{1-e^{-\pi^{2}}}xye^{-y^{2}}}$$` -- Esperanza de `\(Y\)` condicionada por `\(X\)`: -- `$$E\left[Y\mid X=x\right]=\int_{0}^{\pi}yf_{Y|X}(y|x)dy=\int_{0}^{\pi}y\frac{2ye^{-y^{2}}}{1-e^{-\pi^{2}}}dy=\frac{2}{1-e^{-\pi^{2}}}\int_{0}^{\pi}y^{2}e^{-y^{2}}dy$$` -- <br> La función `\(y^{2}e^{-y^{2}}\)` no puede integrarse analíticamente, pero puede calcularse la esperanza anterior utilizando matlab/octave: ```octave function f=f(y) f=2*y*exp(-y^2)/(1-exp(-pi^2)); endfunction mu=quad(@(y) y.*f(y),0,pi) ``` ``` ## mu = 0.88610 ``` --- ### .blue[Ejemplo 1:] * Esperanza de `\(X\)` condicionada por `\(Y\)`: -- `$$E\left[X\mid Y=y\right]=\int_{0}^{1}xf_{X|Y}(x|y)dx=\int_{0}^{1}x2xdx=2\left[\frac{x^{3}}{3}\right]_{0}^{1}=\frac{2}{3}$$` -- <br><br> * Nótese que .red[en este ejemplo] la esperanza de `\(X\)` condicionada por `\(Y\)` no depende del valor de `\(Y\)`, y la esperanza condicionada de `\(Y\)` por el valor de `\(X\)` no depende de `\(X\)` (cosa que ya podíamos sospechar ya que lo mismo ocurría con las densidades condicionales). -- * Esto es otra consecuencia de la independencia entre `\(X\)` e `\(Y\)`. --- ### .blue[Ejemplo 1:] Si volvemos a los 5000 valores observados del vector `\((X,Y)\)` y representamos la función: `$$\mu_{_Y}(x)=E[Y | X=x] = 0.8861$$` esta función es una recta horizontal que corresponde al valor medio de `\(Y\)` para cada `\(x\)`: .pull-left[ <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-9-1.png" style="display: block; margin: auto;" /> ] .pull-right[ <br> Por tanto, da igual lo que valga la `\(x\)`, el valor esperado de `\(Y\)` es siempre el mismo (0.8661) `\(\Longrightarrow\)` el valor de `\(x\)` no informa sobre `\(Y\)` (son independientes). ] --- ### .blue[Ejemplo 1:] Asimismo, si representamos la función: `$$\mu_{_X}(y)=E[X | Y=y] = \frac{2}{3}$$` obtenemos una recta vertical que corresponde al valor medio de `\(X\)` para cada `\(y\)`: .pull-left[ <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-10-1.png" style="display: block; margin: auto;" /> ] .pull-right[ <br> Vemos que da igual lo que valga la `\(y\)`, el valor esperado de `\(X\)` es siempre el mismo (2/3) `\(\Longrightarrow\)` el valor de `\(y\)` no informa sobre `\(X\)` (son independientes). ] --- ### .blue[Ejemplo 2:] Consideremos ahora el vector aleatorio `\((X,Y)\)` con función de densidad: `$$\Large{f(x,y)=\lambda (x+y^2), \;\;\;\; 0\le x\le 1;\;\; 0\le y\le 1}$$` <br> -- #### .blue[Cálculo del valor de λ:] -- `$$1=\int_{0}^{1}\int_{0}^{1}f(x,y)dydx=\lambda\int_{0}^{1}\int_{0}^{1}(x+y^{2})dydx=\lambda\left\{ \int_{0}^{1}\int_{0}^{1}xdydx+\int_{0}^{1}\int_{0}^{1}y^{2}dydx\right\} =$$` -- `$$=\lambda\left\{ \int_{0}^{1}x\left(\int_{0}^{1}dy\right)dx+\int_{0}^{1}\left(\int_{0}^{1}y^{2}dy\right)dx\right\} =\lambda\left\{ \int_{0}^{1}x\left[y\right]_{0}^{1}dx+\int_{0}^{1}\left[\frac{y^{3}}{3}\right]_{0}^{1}dx\right\} =$$` -- `$$=\lambda\left\{ \int_{0}^{1}xdx+\int_{0}^{1}\frac{1}{3}dx\right\} =\lambda\left\{ \left[\frac{x^{2}}{2}\right]_{0}^{1}+\frac{1}{3}\left[x\right]_{0}^{1}\right\} =\lambda\left(\frac{1}{2}+\frac{1}{3}\right)=\lambda\frac{5}{6}\,\,\,\Longrightarrow\,\,\,\lambda=\frac{6}{5}$$` --- ### .blue[Ejemplo 2:] Representación gráfica de `\(\large{f(x,y)=\frac{6}{5}(x+y^{2})}\)`: <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-11-1.png" style="display: block; margin: auto;" /> [Pulsar aquí para rotar esta figura de forma interactiva](sup3DInteractiva2.html) --- ### .blue[Ejemplo 2:] `$$\large{f(x,y)=\frac{6}{5}(x+y^{2})}$$` #### .blue[Densidad marginal de _X_:] -- `$$f_{X}\left(x\right)=\int_{0}^{1}f(x,y)dy=\frac{6}{5}\int_{0}^{1}(x+y^{2})dy=\frac{6}{5}\left[xy+\frac{y^{3}}{3}\right]_{0}^{1}=\frac{6}{5}\left(x+\frac{1}{3}\right)$$` -- <br> #### .blue[Densidad marginal de _Y_:] `$$f_{Y}\left(y\right)=\int_{0}^{1}f(x,y)dx=\frac{6}{5}\int_{0}^{1}(x+y^{2})dx=\frac{6}{5}\left[\frac{x^{2}}{2}+y^{2}x\right]_{0}^{1}=\frac{6}{5}\left(\frac{1}{2}+y^{2}\right)$$` -- <br><br> En este caso `\(X\)` e `\(Y\)` .red[ __no son independientes__] pues `\(f(x,y) \neq f_X(x)\cdot f_Y(y)\)` --- ### .blue[Ejemplo 2:] `$$\large{f(x,y)=\frac{6}{5}(x+y^{2})}$$` #### .blue[Densidad condicional de _Y_ dado el valor de _X_:] `$$f_{Y|X}\left(y|x\right)=\frac{f(x,y)}{f_{X}\left(x\right)}=\frac{\frac{6}{5}(x+y^{2})}{\frac{6}{5}\left(x+\frac{1}{3}\right)}=\frac{(x+y^{2})}{\left(x+\frac{1}{3}\right)}$$` <br> -- #### .blue[Densidad condicional de _X_ dado el valor de _Y_:] `$$f_{X|Y}\left(x|y\right)=\frac{f(x,y)}{f_{Y}\left(y\right)}=\frac{\frac{6}{5}(x+y^{2})}{\frac{6}{5}\left(\frac{1}{2}+y^{2}\right)}=\frac{(x+y^{2})}{\left(\frac{1}{2}+y^{2}\right)}$$` --- ### .blue[Ejemplo 2:] `$$\large{f(x,y)=\frac{6}{5}(x+y^{2})}$$` #### .blue[Esperanza de _Y_ condicionada por _X_:] -- `$$E\left[Y|X=x\right]=\int_{0}^{1}yf_{Y|X}\left(y|x\right)dy=\int_{0}^{1}y\frac{(x+y^{2})}{\left(x+\frac{1}{3}\right)}dy=\frac{1}{\left(x+\frac{1}{3}\right)}\left[x\frac{y^{2}}{2}+\frac{y^{4}}{4}\right]_{0}^{1}=$$` -- `$$=\frac{\frac{1}{2}\left(x+\frac{1}{2}\right)}{\left(x+\frac{1}{3}\right)}=\frac{3}{4}\left(\frac{2x+1}{3x+1}\right)$$` -- #### .blue[Esperanza de _X_ condicionada por _Y_:] -- `$$E\left[X|Y=y\right]=\int_{0}^{1}xf\left(x|y\right)dx=\int_{0}^{1}x\frac{(x+y^{2})}{\left(\frac{1}{2}+y^{2}\right)}dx=\frac{1}{\left(\frac{1}{2}+y^{2}\right)}\left[\frac{x^{3}}{3}+y^{2}\frac{x^{2}}{2}\right]_{0}^{1}=$$` -- `$$\frac{\frac{1}{3}+\frac{1}{2}y^{2}}{\frac{1}{2}+y^{2}}=\frac{2+3y^{2}}{3+6y^{2}}$$` --- ### .blue[Ejemplo 2:] La gráfica siguiente muestra 25000 observaciones del vector `\((X,Y)\)`: <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-12-1.png" style="display: block; margin: auto;" /> --- ### .blue[Ejemplo 2:] Si superponemos la función `\(\mu_{_Y}(x)=E[y|X=x]=\frac{3}{4}\left(\frac{2x+1}{3x+1}\right)\)`: .pull-left[ <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-13-1.png" style="display: block; margin: auto;" /> ] -- <br><br> La linea roja es el valor esperado de `\(Y\)` para cada `\(X\)`. Cuando el valor de `\(X\)` es pequeño la esperanza de `\(Y\)` es más alta; a medida que aumenta el valor de `\(X\)` disminuye el valor esperado de `\(Y\)` `\(\Longrightarrow\)` El valor de `\(X\)` informa sobre `\(Y\)` --- ### .blue[Ejemplo 2:] Asimismo, si superponemos la función `\(\mu_{_X}(y)=E[X|Y=y]=\frac{2+3y^{2}}{3+6y^{2}}\)` obtenemos: .pull-left[ <img src="tema3-2_Distribuciones_Multivariantes_files/figure-html/unnamed-chunk-14-1.png" style="display: block; margin: auto;" /> ] -- <br><br> La linea azul es el valor esperado de `\(X\)` para cada `\(Y\)`. A medida que `\(Y\)` aumenta, el valor esperado de `\(X\)` disminuye. `\(\Longrightarrow\)` El valor de `\(Y\)` informa sobre `\(X\)`.