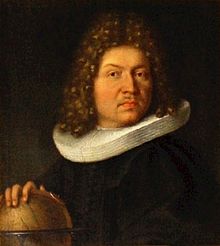

class: center, middle, inverse, title-slide # Estadística y Procesos Estocásticos <br> Tema 2: Variables Aleatorias ### <br><br><br><br><br><br><br>Grado en Ingeniería en Tecnologías de la Telecomunicación --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/asp/descargas/azar.jpg) background-size: cover background-position: 15% 45% class: inverse, top, left # 6. Distribuciones de probabilidad discretas especiales --- ## Distribuciones de probabilidad especiales En esta sección nos ocuparemos de algunas distribuciones de probabilidad que hemos llamado _"especiales"_ por su uso frecuente en las aplicaciones prácticas en el ámbito de las telecomunicaciones: -- .pull-left[ #### .blue[Distribuciones discretas] - Bernoulli - Binomial - De Poisson ] -- .pull-right[ #### .blue[Distribuciones continuas] - Exponencial - Weibull - Uniforme - Normal ] --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/stat/webEyPE/imagenes/darkGaussianBlur.jpg) background-size: cover class: inverse, center, middle # Distribución de Bernoulli --- ## Distribución de Bernoulli -- .pull-left[  [Jacob Bernoulli (1654-1705)](https://en.wikipedia.org/wiki/Jacob_Bernoulli) ] -- .pull-right[ Esta distribución aparece asociada a fenómenos aleatorios en los que sólo son posibles dos resultados, .red[ __éxito__ (con probabilidad p)] y .red[ __fracaso__ (con probabilidad 1-p)]. La variable aleatoria: `$$X=\begin{cases} 1 & \textrm{Si ocurre éxito}\\ 0 & \textrm{Si ocurre fracaso} \end{cases}$$` tiene como distribución de probabilidad: .resalta[ `$$P(X=k)=p^k(1-p)^{1-k},\;\;k=0,1$$` ] ] -- o de manera equivalente: `$$P(X=1)=p \;\;\;\;\;\;\;\;P(X=0)=1-p$$` -- Esta distribución se denomina .red[ __distribución de Bernoulli de parámetro p__ ] y se denota de la forma `\(X\approx Be(p)\)` --- ## Distribución de Bernoulli ### .blue[Ejemplos] 1. Se lanza al aire una moneda equilibrada y se define `\(X=1\)` si sale cara y `\(X=0\)` si sale cruz. Entonces `\(X\approx Be(\frac{1}{2})\)`. -- 2. Se elige al azar una bola de una urna donde hay 20 bolas blancas y 30 negras; se define `\(X=0\)` si sale blanca y `\(X=1\)` si sale negra. Entonces `\(X\approx Be(\frac{3}{5})\)` -- 3. Un router recibe paquetes de datos; cada paquete puede llegar completo (con probabilidad 0.99) o incompleto (con probabilidad 0.01). Si definimos `\(X=1\)` si el paquete llega completo y `\(X=0\)` si llega incompleto, entonces `\(X\approx Be(0.99)\)` --- ## Distribución de Bernoulli. Si `\(\LARGE{X\approx Be(p)}\)`: ### .blue[Esperanza] .resalta[ `$$\Large{E[X]=p}$$` ] -- En efecto: `\(E\left[X\right]=\sum_{k=0}^{1}kP\left(X=k\right)=0\cdot\left(1-p\right)+1\cdot p=p\)` -- ### .blue[Varianza] .resalta[ `$$\Large{Var(X)=p(1-p)}$$` ] -- En efecto: `\(Var\left(X\right)=E\left[X^{2}\right]-\left(E\left[X\right]\right)^{2}=\sum_{k=0}^{1}k^{2}P\left(X=k\right)-p^{2}=0^{2}\cdot\left(1-p\right)+1\cdot p-p^{2}=p\left(1-p\right)\)` --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/stat/webEyPE/imagenes/darkGaussianBlur.jpg) background-size: cover class: inverse, center, middle # Distribución Binomial --- ## Distribución Binomial -- Es el nombre que recibe la distribución de probabilidad de la variable: `\(\Large{X}\)` = _"Número de éxitos en `\(\Large{n}\)` experimentos __independientes__ de Bernoulli de parámetro `\(\Large{p}\)`"_ -- .resalta[ `$$\Large{P\left(X=k\right)=\binom{n}{k}p^{k}\left(1-p\right)^{n-k},\,\,\,k=0,1,\dots,n}$$` ] -- Se dice entonces que `\(X\)` sigue una .red[ __distribución binomial de parámetros n y p__ ] y se denota `\(X\approx B(n,p)\)`. --- ## Distribución Binomial ### .blue[Ejemplos] 1. Se lanza 4 veces al aire una moneda equilibrada y se considera `\(X\)`= _"Número de caras en los cuatro lanzamientos"_. Entonces `\(X\approx B(4,\frac{1}{2})\)` -- 2. En un router se reciben paquetes de datos de 8 bits de longitud. Cada bit puede ser, independientemente del resto de los bits, correcto con probabilidad `\(p\)` o erróneo con probabilidad `\(1-p\)`. Si `\(X\)` es el número de bits correctos en un paquete, entonces `\(X\approx B(8,p)\)` -- 3. Un 60% de los paquetes de datos que se reciben en un conmutador de red de una empresa van dirigidos hacia el exterior, y el otro 40% van dirigidos a máquinas de la propia red local. En un estudio del tráfico de esta red en el que se eligen 50 paquetes al azar, la variable `\(X\)`=_"Número de paquetes dirigidos al exterior"_ sigue una distribución `\(B(50, 0.6)\)` --- ### .blue[Deducción de la función de probabilidad de la distribución binomial.] En el ejemplo 2 anterior, sea `\(X\)`=_"Número de bits correctos en un paquete de 8 bits"_ `\(\approx B(8,p)\)`. Calculemos `\(P(X=3)\)` -- * Llamemos `\(B\)` al suceso _"el bit se recibe bien"_ (es correcto) y `\(B^c\)` a su suceso contrario (se recibe mal), siendo `\(P(B)=p\)` y `\(P(B^c)=1-p\)`. -- * Una de las formas en que se pueden recibir sólo 3 bits correctos es que sean los tres primeros: `$$B\cap B\cap B\cap B^c\cap B^c\cap B^c\cap B^c\cap B^c$$` -- * Como cada bit es correcto o no independientemente del resto, la probabilidad de que ocurra el suceso anterior es: `$$P(B\cap B\cap B\cap B^c\cap B^c\cap B^c\cap B^c\cap B^c) =$$` `$$= P(B)P(B)P(B)P(B^c)P(B^c)P(B^c)P(B^c)P(B^c)=$$` `$$=P(B)^3\cdot P(B^c)^5 = p^3\cdot (1-p)^5$$` --- ### .blue[Deducción de la función de probabilidad de la distribución binomial.] * El número de formas en que pueden recibirse 3 bits correctos entre 8 coincide con el número de formas en que podemos elegir 3 posiciones entre 8, para colocar en ellas las `\(B\)`: `$$\binom{8}{3}=\frac{8!}{5!\cdot 3!}$$` -- * La probabilidad total de recibir 3 bits correctos entre 8 será la .red[suma de las probabilidades] de cada una de estas `\(\binom{8}{3}\)` formas. Como cada una de ellas tiene la misma probabilidad `\(p^3(1-p)^5\)`, la probabilidad total será: `$$P(X=3)=\binom{8}{3}p^3(1-p)^5$$` -- * En general, si `\(X\approx B(n,p)\)`: `$$P\left(X=k\right)=\binom{n}{k}p^{k}\left(1-p\right)^{n-k},\,\,\,k=0,1,\dots$$` --- ### .blue[Representación gráfica de la distribución binomial para _n_=8 y varios valores de _p_] <img src="tema2-3_Distribuciones_Especiales_Discretas_files/figure-html/unnamed-chunk-1-1.png" style="display: block; margin: auto;" /> --- ### .blue[Esperanza de la distribución binomial.] .resalta[ `$$\Large{E[X]=np}$$` ] <br> -- .blue[_Demostración:_] `$$E\left[X\right]=\sum_{k=0}^{n}kP\left(X=k\right)=\sum_{k=0}^{n}k\binom{n}{k}p^{k}\left(1-p\right)^{n-k}=$$` -- `$$\sum_{k=1}^{n}k\frac{n!}{k!\left(n-k\right)!}p^{k}\left(1-p\right)^{n-k}=np\sum_{k=1}^{n}\frac{\left(n-1\right)!}{\left(k-1\right)!\left(n-k\right)!}p^{k-1}\left(1-p\right)^{n-k}=$$` -- `$$\underset{(1)}{=}np\sum_{k=0}^{n-1}\frac{\left(n-1\right)!}{k!\left(n-k-1\right)!}p^{k}\left(1-p\right)^{n-k-1}\underset{(2)}{=}np\left[p+\left(1-p\right)\right]^{n-1}=np$$` <br> .small[(1) Hemos hecho el cambio] `\(k-1\,\,\rightarrow\,k\)` .small[(2) Hemos aplicado la fórmula del binomio de Newton:] `\(\left(a+b\right)^{n}=\sum_{k=0}^{n}\binom{n}{k}a^{n}b^{n-k}\)` --- ### .blue[Varianza de la distribución binomial.] .resalta[ `$$\Large{Var(X)=np(1-p)}$$` ] <br> -- .blue[_Demostración:_] La veremos más adelante utilizando el concepto de _función característica_, que simplifica notablemente el cálculo. --- background-image: url(http://www.dma.ulpgc.es/profesores/personal/stat/webEyPE/imagenes/darkGaussianBlur.jpg) background-size: cover class: inverse, center, middle # Distribución de Poisson --- ## Distribución de Poisson .pull-left[  [Siméon D. Poisson (1781–1840)](https://en.wikipedia.org/wiki/Sim%C3%A9on_Denis_Poisson) ] -- .pull-right[ Aparece asociada a la variable aleatoria consistente en .red[ __contar__] el número de ocurrencias de cierto proceso que se caracterizan por estar distribuidas: * independientemente unas de otras * de modo completamente aleatorio * con tasa (densidad) constante * en un medio continuo. ] --- ## Distribución de Poisson ### .blue[Ejemplos:] * El número de llamadas que llegan a una centralita telefónica durante un intervalo de tiempo. -- * El número de paquetes de datos que llegan a un conmutador durante un intervalo de tiempo. -- * El número de partículas emitidas por un compuesto radiactivo durante un cierto periodo. -- * El número de estrellas visibles en una porción rectangular del firmamento. -- * El número de accidentes de tráfico que ocurren en una región durante un periodo determinado. --- ## Distribución de Poisson Sean: * `\(X_t\)` = _"Número de eventos que ocurren en un periodo de duración t."_ -- * `\(\lambda\)` = _tasa media de ocurrencia .blue[por unidad de tiempo]_ de los eventos de interés (número medio de eventos por unidad de tiempo). -- `\(\large{X_t}\)` sigue una .red[ __distribución de Poisson__] de parámetro `\(\lambda\)`, y lo denotaremos `\(\large{X_t \approx P(\lambda)}\)`, si su función de probabilidad es de la forma: .resalta[ `$$\Large{P(X_t=k)=e^{-\lambda t}\frac{(\lambda t)^k}{k!}}$$` ] --- ### .blue[Distribución de Poisson. Ejemplo:] Supongamos que el número de paquetes que llegan a un router sigue una distribución de Poisson de parámetro `\(\lambda\)`= 3 paquetes por `\(\mu seg\)`. * La probabilidad de que en 1 `\(\mu seg\)` lleguen 2 paquetes es: -- `$$P(X_1=2)=e^{-3}\frac{3^2}{2!}=0.224$$` -- * La probabilidad de que en 1 `\(\mu seg\)` lleguen 3 o más paquetes es: `$$P\left(X_1\ge3\right)=1-P\left(X_1<3\right)=1-\left[P\left(X_1=0\right)+ P\left(X_1=1\right)+P\left(X_1=2\right)\right]=$$` `$$=1-\left(e^{-3}\frac{3^{0}}{0!}+e^{-3}\frac{3^{1}}{1!}+e^{-3}\frac{3^{2}}{2!}\right)=0.58$$` -- * La probabilidad de que en 2 `\(\mu seg\)` lleguen 5 paquetes es: `$$P\left(X_{2}=5\right)=e^{-3\cdot2}\frac{(3\cdot2)^{5}}{5!}=0.1606$$` --- ### .blue[Representación gráfica de la distribución de Poisson para varios valores de] `\(\Large{\lambda}\)` <img src="tema2-3_Distribuciones_Especiales_Discretas_files/figure-html/unnamed-chunk-2-1.png" style="display: block; margin: auto;" /> --- ### .blue[Deducción de la función de probabilidad de la distribución de Poisson] * Sea `\(X\)` una variable aleatoria con distribución de Poisson que cuenta el número de eventos que ocurren al azar e independientemente en un intervalo `\([0,t]\)` siendo `\(\lambda t\)` el número esperado de eventos en ese intervalo. <img src="tema2-3_Distribuciones_Especiales_Discretas_files/figure-html/unnamed-chunk-3-1.png" style="display: block; margin: auto;" /> -- * Dividimos el intervalo `\([0,t]\)` en `\(n\)` partes iguales; para un `\(n\)` lo suficientemente grande ( `\(n \rightarrow \infty\)` ), las partes en que lo hemos dividido llegan a hacerse tan pequeñas que en cada una de ellas puede ocurrir como máximo un evento, o ninguno. <img src="tema2-3_Distribuciones_Especiales_Discretas_files/figure-html/unnamed-chunk-4-1.png" style="display: block; margin: auto;" /> -- * Como el número esperado de eventos en `\([0,t]\)` es `\(\lambda t\)`, la probabilidad de que ocurra un evento en una de las `\(n\)` partes en que hemos dividido el intervalo puede aproximarse por `\(p=\frac{\lambda t}{n}\)` --- ### .blue[Deducción de la función de probabilidad de la distribución de Poisson] * Dado que los distintos eventos .red[ocurren de forma independiente], la probabilidad de que ocurran `\(k\)` eventos en las `\(n\)` partes en que hemos dividido el intervalo `\([0,t]\)` puede aproximarse por una binomial `\(B(n,p)\)`, y entonces: -- $$ P(X=k) = \underset{n\rightarrow\infty}{\lim}\binom{n}{k}p^{k}\left(1-p\right)^{n-k}=\underset{n\rightarrow\infty}{\lim}\binom{n}{k}\left(\frac{\lambda t}{n}\right)^{k}\left(1-\frac{\lambda t}{n}\right)^{n-k}$$ -- `$$\lim_{n\rightarrow\infty}\frac{n!}{(n-k)!k!}\left(\frac{\lambda t}{n}\right)^{k}\left(1-\frac{\lambda t}{n}\right)^{n-k}=$$` -- `$$\lim_{n\rightarrow\infty}\frac{n(n-1)...(n-k+1)}{n^{k}}\frac{(\lambda t)^{k}}{k!}\left(1-\frac{\lambda t}{n}\right)^{n-k}=$$` -- `$$=\frac{(\lambda t)^{k}}{k!}\lim_{n\rightarrow\infty}1\cdot\left(1-\frac{1}{n}\right)\cdot...\cdot\left(1-\frac{k-1}{n}\right)\left(1-\frac{\lambda t}{n}\right)^{n}\left(1-\frac{\lambda t}{n}\right)^{-k}=$$` -- `$$\frac{(\lambda t)^{k}}{k!}1\cdot1\cdot\dots\cdot e^{-\lambda t}\cdot1=\frac{(\lambda t)^{k}}{k!}e^{-\lambda t}=\frac{(\lambda t)^{k}}{k!}e^{-\lambda t}$$` --- ### .blue[Esperanza de la distribución de Poisson] .resalta[ $$ \Large{E\left[X\right]=\lambda t}$$ ] -- <br> #### .blue[ _Demostración:_] `$$E\left[X\right]=\sum_{k=0}^{\infty}kP\left(X=k\right)=\sum_{k=0}^{\infty}ke^{-\lambda t}\frac{\left(\lambda t\right)^{k}}{k!}=e^{-\lambda t}\lambda t\sum_{k=1}^{\infty}\frac{\left(\lambda t\right)^{k-1}}{\left(k-1\right)!}=$$` -- `$$e^{-\lambda t}\lambda t\sum_{k=0}^{\infty}\frac{\left(\lambda t\right)^{k}}{k!}=e^{-\lambda t}\lambda te^{\lambda t}=\lambda t$$` --- ### .blue[Varianza de la distribución de Poisson] .resalta[ $$ \Large{Var\left(X\right)=\lambda t}$$ ] -- <br> #### .blue[ _Demostración:_] La veremos más adelante utilizando el concepto de _función característica_, que simplifica notablemente el cálculo.